資料中心面對新興技術帶來的海量資料,迫切需要找到變革之道,而隨著電介面資料速度逐漸觸及物理極限,資料中心需要從根本改變交換器設計方式才能突破瓶頸。共同封裝光學元件(CPO)打破過往交換器設計,有望為資料中心帶來光明前景。本文將探討資料中心改革的關鍵因素,並介紹交換器連接技術的演進過程。

隨著人工智慧、自動駕駛汽車和數位分身等技術突飛猛進,海量資料在全球持續交換,資料中心亟須擴充其資料處理能力。不僅如此,在家辦公的風氣、高位元率內容的傳遞、雲端運算的普及、元宇宙規模的擴大,以及虛擬實境成為主流,這些新興趨勢進一步加劇資料中心的升級需求。

一些超大規模企業開始藉助新的運算技術(例如支援機器學習的處理器),來更有效地處理海量資料。然而,龐大的資料量和更高的傳輸速率帶來了許多新的挑戰。為了管理海量資料,需要使用高頻寬乙太網路交換器來連接大量伺服器。

隨著新興技術不斷發展,資料產生和處理量也急遽攀升,超大規模製造商必須跟上最新潮流,並且努力實現最佳的實體空間、功耗、成本、可靠性和可擴充性。想要達成這些目標,他們需要在運算、布線、連接和交換架構方面進行創新。

共同封裝光學元件(Co-packaged Optics, CPO)為其中一項創新,針對已極度僵化的資料中心交換器設計,進行了一場徹頭徹尾的變革。儘管很多人將共同封裝光學元件視為光明未來,共同封裝光學元件卻也帶來許多挑戰:在功耗和成本之間取得平衡、為實現互通性進行標準化、確保可靠性和可維修性,以及部署新的測試和驗證方法。本文將深入探討這些考量因素,並簡要介紹交換器連接技術的演進。

資料中心改革考量因素

交換器晶片

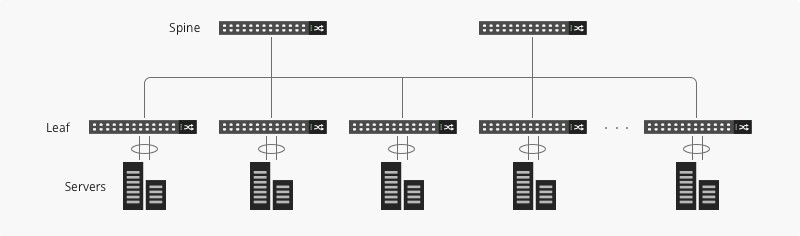

一走入資料中心,就會看到滿坑滿谷的基礎設施,其中部署了各式各樣的交換器。如果絕大部分的資料中心流量是由進出資料中心的資料(垂直傳送的流量)所組成,那麼採三層匯集結構的交換器將占據主導地位。隨著分散式運算技術興起,同時伺服器之間的流量(橫向傳送的流量)暴增,資料中心開始採用更穩健的「spine-leaf」架構,如圖1所示。在橫向傳送流量呈指數級成長的情況下,前所未有的資料中心流量讓可勝任此任務之新型交換器的發展腳步大受延誤。

圖1 事實證明,spine-leaf架構比傳統的三層架構,更能應付不斷增加的橫向資料流量 (圖片來源:FS Community)

圖1 事實證明,spine-leaf架構比傳統的三層架構,更能應付不斷增加的橫向資料流量 (圖片來源:FS Community)

交換器的核心是一個專用的特定應用積體電路(ASIC),每秒傳輸速率高達Terabit。過去,這類ASIC大多由交換器製造商自行開發。然而,隨著商用晶片(由第三方晶片供應商開發,接著銷售給交換器製造商進行最終產品整合)的興起,這種模式已經改變。

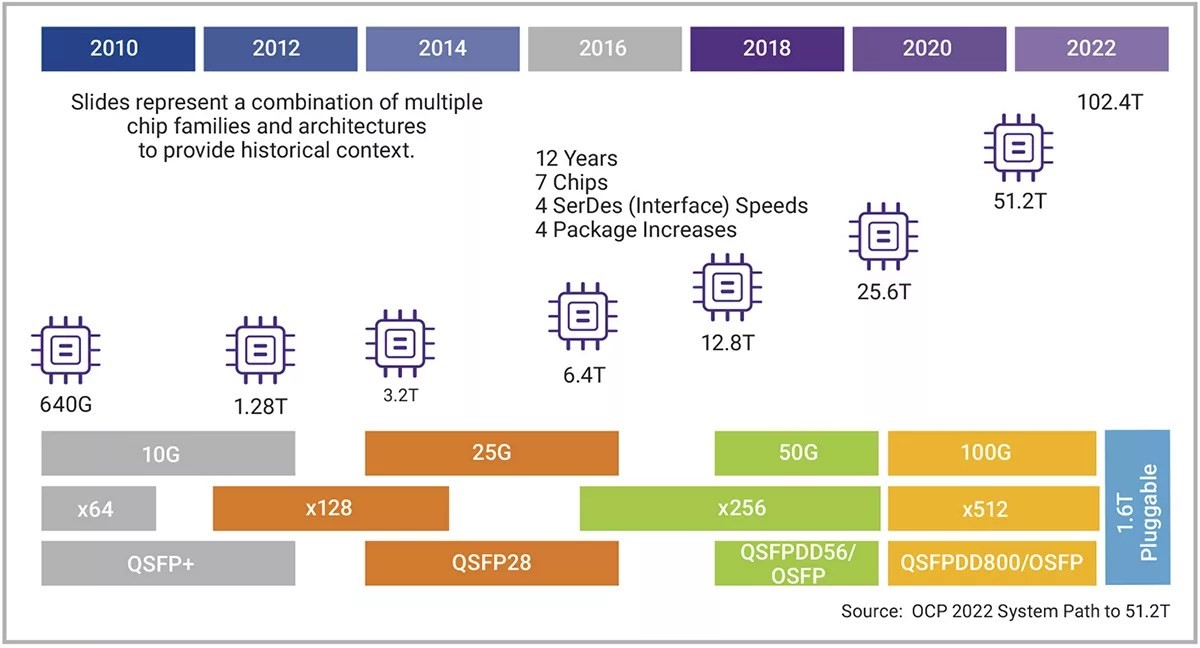

近來,資料中心流量幾乎每兩三年就成長一倍(圖2),促使Intel、Nvidia和Broadcom等晶片公司爭相開發可有效管理流量的交換器晶片。然而,當資料在各個交換器之間移動時,在到達交換器ASIC之前會遇到另一個瓶頸:光學元件和ASIC之間的電氣路徑。

圖2 專家預測,交換器晶片的性能每兩年增加一倍

圖2 專家預測,交換器晶片的性能每兩年增加一倍

資料中心光學元件

在傳統交換器中,交換式ASIC透過印刷電路板上的多個通道,將資料傳送到交換器機箱前面板上的埠。這些埠及其可插拔模組隨著交換器晶片的發展而逐漸演進,速度或每條鏈路的通道數均大幅增加。每埠的傳輸速率從最初的SFP 1Gbps鏈路,迅速成長為支援高達800Gbps的最新型QSFP-DD 800。現在可以使用配有電介面纜線(又稱為直接連接銅纜(DAC))的模組,將交換器彼此連接起來。不過電介面纜線的問題在於,它的速度和傳輸距離無法滿足大多數現代資料中心通訊的需求。此時,透過光纜將資料中心的交換器進行光互連,是比使用電介面纜線更好的選擇,因為它可維持遠距離訊號完整性,並且功耗更低,雜訊抗擾能力更好。

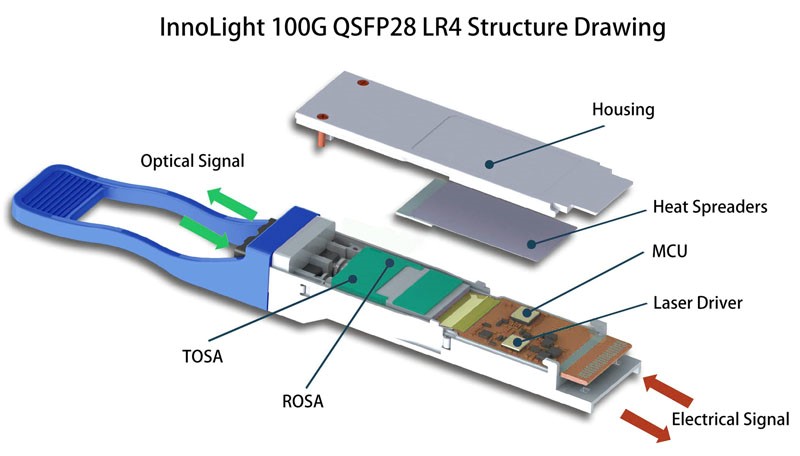

如果要使用光纜,則交換器埠需要配備收發器模組,以便將訊號從交換器晶片的電域,轉換到纜線的光域,反之亦然。圖3爲傳統的收發器,它有兩個關鍵元件:光發射器次模組(TOSA),負責電光轉換;而光接收器次模組(ROSA)則負責反方向的轉換。光收發器的銅指(Copper Finger)插頭可插入切換器,光連接器則插入切換器的另一端。光連接器有各種截然不同的外觀尺寸和類型可以選擇。隨著新的收發器和纜線技術進入市場,多源協定組織(MSA)致力於確保不同供應商產品的標準化和互通性。

圖3 此QSFP28 LR4收發器包含一個TOSA和ROSA,可在電域和光域之間進行轉換 (圖片來源:InnoLight)

圖3 此QSFP28 LR4收發器包含一個TOSA和ROSA,可在電域和光域之間進行轉換 (圖片來源:InnoLight)

SerDes

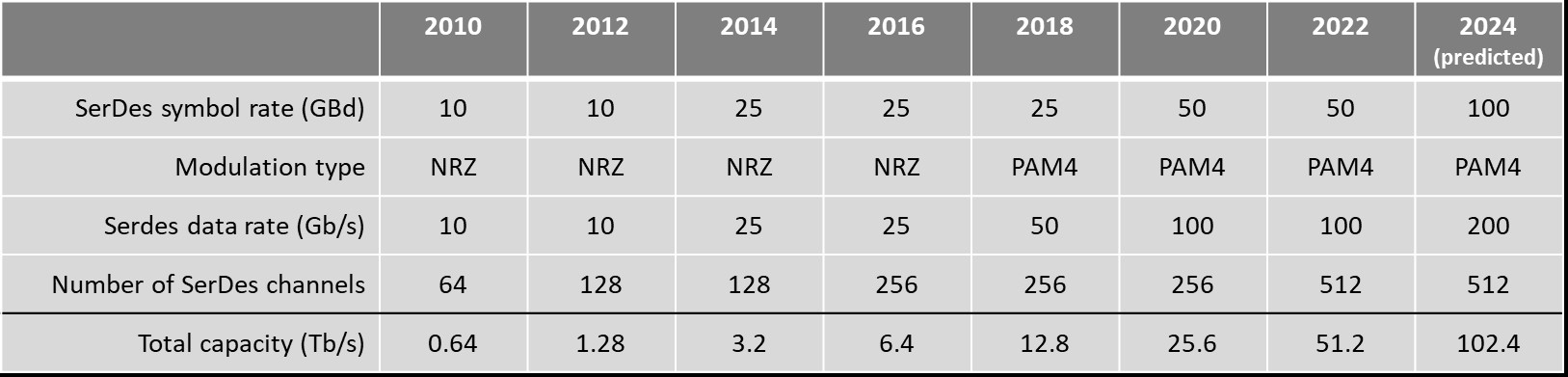

可插拔收發器和ASIC之間的路徑,由電介面串列和解串列(SerDes)電路組成。隨著交換器晶片的規模不斷擴大,電介面互連也必須等比擴大。交換器供應商藉由增加SerDes通道的數量或速度來實現此目標(表1)。當今最高頻寬的交換器晶片可支援51.2Tbps的速率。製造商藉由將100Gbps PAM4調變SerDes線路的數量增加一倍(從256增加至512),來實現此速率。

表1 交換器晶片性能逐年成長

表1 交換器晶片性能逐年成長

如果使用51.2Tbps ASIC作為16個埠的前面板,則交換器在每個埠上都要有一條3.2T鏈路,以便充分利用提供的交換容量。當今最高頻寬的可插拔部署提供每埠800Gbps的速率,但標準組織正致力於提高通道密度和速度,以便擴充這些鏈路的容量,例如結合16個200Gbps的通道,將容量擴充至3.2T。

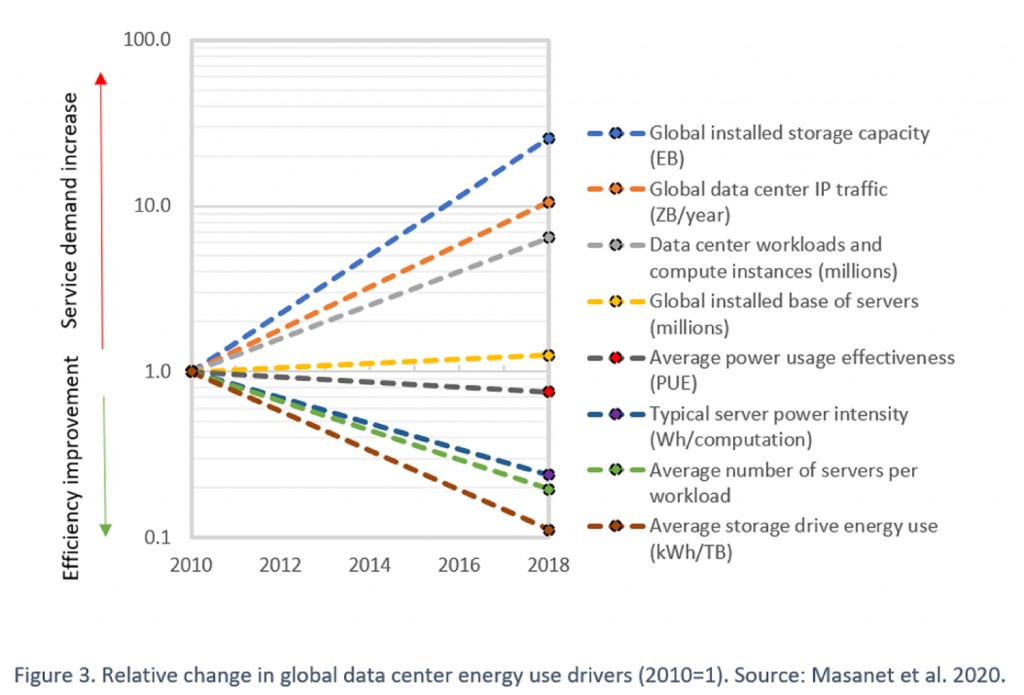

產業正專注研究224Gbps技術,以便在前面板使用1.6Tbps介面。然而,隨著速度不斷提升,訊號傳輸方式也變得更為複雜,每位元功耗也隨之增加,帶來了更多的挑戰。朝向224Gbps速率的演進,讓我們成功避開2010年代人們做出的悲觀預測:隨著資料中心流量增加,耗電量會大幅飆升。圖4顯示多項競爭要素讓資料中心得以維持相對穩定的功耗。

圖4 雖然資料需求量仍不斷攀升,但近來節能效率也有了顯著成長,讓人們10年前預測的能源用量飆升問題獲得妥善控制 (資料來源:Masanet, et. al., 2020.)

圖4 雖然資料需求量仍不斷攀升,但近來節能效率也有了顯著成長,讓人們10年前預測的能源用量飆升問題獲得妥善控制 (資料來源:Masanet, et. al., 2020.)

隨著網路布局和散熱系統不斷更新,單一交換器的資料傳輸速率也迅速提升,不但減少了所需的裝置數量,同時也縮減了占地面積和整體功耗。然而,技術專家指出,我們已逐漸逼近現有伺服器尺寸內,電介面通道資料速率的物理極限。雖然互連技術取得的突破有助於將鏈路速率提高到800Gbps和1.6T,但如果想要再超越這些資料速率,需要從根本上改變交換器設計。

資料中心掀起光學革命 交換器性能更上一層樓(1)

資料中心掀起光學革命 交換器性能更上一層樓(2)