AI已成為兵家必爭之地,無論是IP商、晶片商、系統整合商與雲端平台服務商皆企圖搶下市場大餅。也基於此,Arm不僅積極研發新一代CPU和GPU處理器,更砸重金自行開發核心關鍵元件ML處理器,滿足新世代AI應用需求。

人工智慧(AI)戰火擴大延燒。物聯網(IoT)方興日盛,聯網裝置與數據資料爆發成長,在此情況下,同時又要保障低延遲、安全與個人隱私等要素,促使人工智慧機器學習應用從雲端轉移至邊緣節點。為了讓機器學習技術在邊緣端能充分發揮所長,安謀國際(Arm)近期在北京舉辦Arm Tech活動,詳細探討人工智慧發展趨勢,並提出三大機器學習(ML)晶片設計要點,加速人工智慧產業發展。

掌握三大要點 ML晶片設計一次到位

Arm顧問工程師暨機器學習事業部技術總監Ian Bratt(圖1)表示,該公司認為專用型機器學習晶片須具備幾項特點,包含高效能卷積(Efficient Convolutions)、高效能數據移動(Efficient Data Movement)與可編程/彈性(Programmability/Flexibility)等關鍵技術。

圖1 Arm顧問工程師暨機器學習事業部技術總監Ian Bratt分析,機器學習晶片須符合三大設計需求,因應AI應用的發展。

圖1 Arm顧問工程師暨機器學習事業部技術總監Ian Bratt分析,機器學習晶片須符合三大設計需求,因應AI應用的發展。

Bratt談到,該公司調查透過機器學習處理大量工作量時,主要瓶頸大多都在於卷積處理,因此要提高整體機器學習效率,卷積處理效率的提升是非常關鍵的一環。再者,在功耗設計部分,Arm發現晶片中數據移動所損失的功耗,大於處理每個位元數據本身,換言之,高效率數據移動是影響功耗的關鍵點,也為機器學習第二大設計要素。最後,由於人工智慧為全新領域,神經網路技術在不斷變化,迎合此趨勢,具備可編程與彈性的設計不可或缺。

綜合上述的設計概念,Bratt認為,以Arm現有的處理器IP,著實難以負荷人工智慧與機器學習所須具備的特點。為此該公司抱著從零開始的決心,針對人工智慧和機器學習應用打造全新處理器。

但Bratt也強調,從零開始設計並非捨棄該公司在CPU和GPU處理器方面累積的優勢,相反的,卻是將這些優勢融入於全新的機器學習專用晶片。例如延續Arm在CPU具備的可編程優勢,以及GPU數據處理壓縮能力和高吞吐量的設計特點,將其整合至機器學習晶片設計之中。

整體而言,Arm機器學習處理器專為機器學習重新打造,其基於具高度擴充性的Arm機器學習架構,期能為機器學習應用達到最高的效能與效率。初期第一代機器學習晶片聚焦於行動運算市場,其提供每秒超過4.6兆次運算。透過智慧資料管理,在現實使用情況下的每秒兆次運算(TOPs)有效處理量可進一步提升2~4倍;此外,在溫度與成本限制較多的環境下,提供每瓦每秒超過3兆次運算(TOPs/W)的效能與效率。

手機/筆電通吃 安謀CPU效能直追Core i5

行動運算日趨複雜,加上各種新形態虛擬體驗、人工智慧與機器學習應用與日俱增,手機處理器效能與效率的提升勢在必行。為此,Arm發布新一代Cortex A76行動處理晶片,提供媲美英特爾(Intel)Core i5的高效能處理器,滿足手機與筆電應用市場需求。

Arm技術副總裁暨院士Peter Greenhalgh(圖2)表示,現在智慧手機對於單線性的運算需求不斷提高,其所需的高效能要求直逼筆電等級,促使Arm打造出具備筆電能力的處理器,並將該處理器導入手機應用當中。

圖2 Arm技術副總裁暨院士Peter Greenhalgh表示,Arm新一代CPU的運算效能直追Core i5能力,可滿足筆電與手機應用。

圖2 Arm技術副總裁暨院士Peter Greenhalgh表示,Arm新一代CPU的運算效能直追Core i5能力,可滿足筆電與手機應用。

Arm資深市場行銷總監Ian Smythe(圖3)談到,智慧手機已經成為人們日常使用的行動裝置,大家已對智慧手機快速反應的運作習以為常,卻未意識到智慧手機需要相當高的運算能力。再者,也有許多商務人士出於工作的需求,透過手機使用非常多Office 356雲端服務功能,手機也間接成為另一種取代電腦工作載具。

圖3 Arm資深市場行銷總監Ian Smythe認為,智慧手機的處理能力日益提升,足以逐漸取代某些筆電功能。

圖3 Arm資深市場行銷總監Ian Smythe認為,智慧手機的處理能力日益提升,足以逐漸取代某些筆電功能。

Smythe分析,OEM廠商在選用Arm高階應用處理器時,往往會取決於成本、處理性能與不同應用別需求的考量。新款處理器將提供更好的內存能力,同時提升處理性能,適用於追求高效的產品設計;不過,Cortex A76並非取代既有處理器,而是提供一個新的選擇。舉例來說,某些OEM廠商認為Cortex A75與Cortex A73即能滿足大多數的應用場景,則會繼續沿用該款處理器。此外,以總體處理器占用的面積來看,Cortex A75和Cortex A73面積還是小於Cortex A76,對於成本敏感的廠商,還是比Cortex A76占有優勢。

另一方面,除了手機上的應用,Cortex A76為一款企圖取代筆電處理器的元件。Arm觀察到筆電Always On的趨勢成形,極有可能產生全新尺寸類別的裝置,而這也是Cortex A76率先可能導入的產品類型,提供OEM導入至更大尺寸的行動裝置,從而提升整體裝置生產力。

整體而言,Greenhalgh透露,目前已有兩家SoC廠商將Cortex A76導入於晶片設計當中,而Arm也預期,2019年將有望於聯網的筆電上看到該處理器的蹤影。

人工智慧添戰力 GPU採微架構提升效能

Arm除了CPU添加新的戰力之外,於2018年年初,也推出GPU Mali-G52以及全新旗艦款Mali-G76,兩者都採用Bifrost繪圖架構。透過更寬敞的核心設計,只運用不到兩倍的矽空間,卻可達到兩倍的運算效能,為人工智慧應用注入全新動能。

Mali-G52另一項的特色就是支援int8 dot,此舉對機器學習的效能具有相當大的幫助。儘管高階裝置可能都配備專屬的機器學習處理器或加速器,但Arm合作夥伴會在各類型裝置上配置旗艦款GPU,針對專屬機器學習解決方案進行調適,而其他產品未必採取類似作法。不過就算經過特別調校,目前也只算是剛跨入機器學習這類新興技術的階段,未來幾年產生的應用其規模以及其需求可能遠超過想像。

整體而言,Arm GPU系列分成三個等級(圖4)。低階等級主要針對成本敏感市場,稱為超高效(Ultra-Efficient)GPU系列,也就是說出於成本考慮,可能會在性能與功能上有所折衷,進而優化成本需求;中階等級則是鎖定高性價比的應用需求;而高階旗艦型的GPU,則是完全聚焦於以性能取勝的設計產品。以行動裝置產品設計而言,最大挑戰還是在於功耗與散熱上的設計。

圖4 Arm GPU處理器的設計藍圖

圖4 Arm GPU處理器的設計藍圖

資料來源:Arm

面對多樣化的GPU不同型號與產品定位類別,晶片開發商在選擇GPU時,經常會有一些選擇性障礙的問題,對此Arm資深產品經理Espen Øybø(圖5)談到,該公司IP設計的初步概念發想,會針對不同類型的裝置,考慮相對應的IP設計方案。但這都只是IP設計的思考邏輯,真正IP選擇的決定權還是掌握在晶片商手中,此時關鍵會在於晶片開發的定位設定,若願意花更多預算,選擇高成本產品,則效能相對會提升,選擇的關鍵需交由晶片商權衡晶片開發的成本或性能。針對旗艦級GPU系列,是著眼於下一代應用,除了機器學習應用外,該公司認為手機遊戲應用是下一個推動GPU發展的關鍵應用。

圖5 Arm資深產品經理Espen Øybø認為,機器學習、手遊與擴增實境將是推動下世代GPU發展的關鍵應用。

圖5 Arm資深產品經理Espen Øybø認為,機器學習、手遊與擴增實境將是推動下世代GPU發展的關鍵應用。

也基於此,Mali-G76具備雙材質貼圖對映器(Ttexture Mapper),處理量是上一代Mali-G72的兩倍,效率因此大幅提升。此外,為改進效能密度與耗電,新款GPU優化暫存器,使用數量減半但容量較大的暫存器庫區(Bank),藉此改進空間與能源效率。

Øybø分析,材質對映器為GPU的一部份,實際上功用是進行像素複製與混合,意指提供顏色生成的過濾功能,可從不同位址複製不同數據,並將這些數據混和再一起。對於GPU而言,材質對映器是非常專業等級的功能,例如開發商透過GPU做人機介面(UI)設計或者遊戲製作,大部分GPU要運作的就是使用材質對映器,這也是起初材質對映器一開始只在中階GPU產品G51上面使用的原因。但在G76的訴求,Arm則希望能夠增加數據通道的吞吐量,滿足高複雜度與高解析度遊戲應用,故G76支援雙材質對映器,能取得材質、運算與數據通道上的平衡。

AI應用效能加倍 三大處理器分工合作

整體而言,Bratt談到,Arm相信許多種運算需要特殊的架構,針對某些特殊AI應用勢必無法透過CPU和GPU實現,因此該公司進一步開發ML處理器。例如,照片分析的設計不斷改變,開發者須確保照片分析能符合需求,特別是在矽晶圓設計日益微型化的趨勢下,開發者能在模組上增加更多的晶片、處理器提升效能;因此,在模組內CPU、GPU、ML處理器會進行分工,主要是採用ML處理器進行特殊影像處理。

Arm機器學習事業部商業暨行銷副總裁Dennis Laudick補充,Cortex-A系列CPU可以支援臉部辨識應用,而廠商選擇的關鍵在於其產品對臉部識別的反應速度要求,若是選用Cortex-A系列CPU,初估臉部辨識反應時間為200毫秒,若是用專門的ML處理器預計反應時間可縮減為10毫秒。

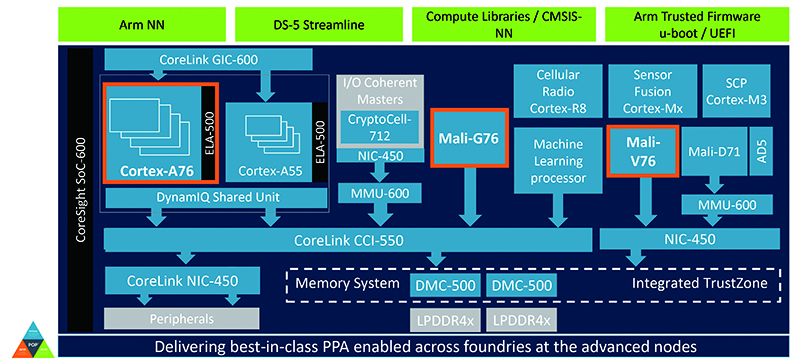

延續上述系統設計問題,Smythe以系統層級分析不同處理器的分工。他提到,無論是Android、Linux或是Windows作業系統,主要都是採用Cortex-A系列處理器(圖6)。由於該公司具備Arm NN提供的API,當出現機器學習的工作負載,可透過API直接導入Cortex-A系列、Mali GPU,或者ML專用處理器處理。換言之,系統區隔會依照不同應用區分,但事實上,無論開發商使用CPU、GPU或ML處理器執行機器學習,在單一SoC系統上,僅有一個系統通訊的總線。這也意味著,若SoC系統中,額外添加一顆的處理器,用於專門處理機器學習的工作負載,其獲得的運算效能,會回歸到系統總效率的層次。

圖6 高階裝置設計系統架構圖

圖6 高階裝置設計系統架構圖

資料來源:Arm

Arm透露,未來Arm系統的設計藍圖,預計在SoC中同時整合Cortex-A系列和ML處理器,甚至是在同一個大小核上進行分工,由Cortex-A系列處理某些工作的負載,而更高程度的機器學習由ML處理器負責。

Dennis談到,在一個SoC設計中,中央位置肯定是CPU,由CPU處理機器學習負載,但若設計場景需要具備大量機器學習的工作負載,該公司的建議採用1個ML處理器加上1個CPU。目前該公司第一代ML處理器主要針對視覺應用,後續將推出更多ML處理器,滿足音訊、安全等不同應用市場。

AI市場熱戰方酣 RISC-V/FPGA技術夾擊

除了CPU、GPU和ML專用處理器之外,實現人工智慧還可透過FPGA與新興的開源處理器基礎架構技術/標準RISC-V予以支援。

面對RISC-V的來勢洶洶,Smythe表示,ARM成立以來面臨很多不同競爭對手,RSIC-V肯定是眾競爭對手之一。但從市場普及率來看,Arm具有非常大的優勢,因為從最小的感測器元件,一路延伸至大型複雜計算系統,皆可看到Arm架構蹤影。相較之下,RSIC-V在生態系統上,還是屬於一個比較局限性的系統,較多用於嵌入式系統、或針對學術處理器的架構,以應用層次區分,與Arm還是有所差異。

另外,在對於高客製化需求的AI市場而言,FPGA的高可編程優勢,可說是占有一定的優勢。對此,Bratt認為,Arm ML專用處理器在效能上高於FPGA,因為FPGA本身並不支援機器學習的工作負載做編譯,而是在FPGA中以堆疊的方式,構成一個機器學習專用的處理器,因此在效率處理上低於Arm ML處理器。

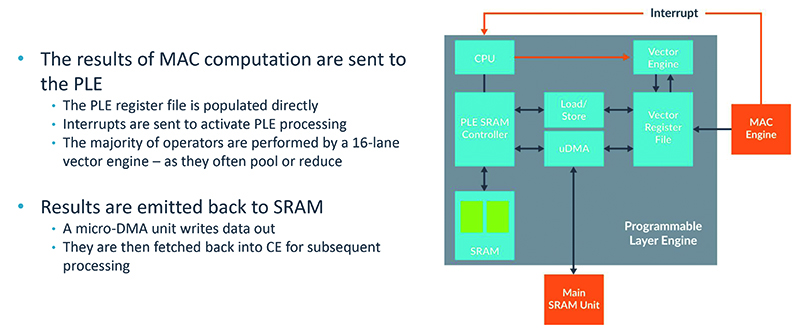

此外,Bratt談到,客製化可分為硬體客製化與神經網路本身的客製化,而Arm也有提供一些專門設計與支援,來支援神經網路本身的客製化,特別是可編程層引擎(Programmable Layer Engine, PLE),可實現客製化設計的部分(圖7)。

圖7 Arm ML處理器可編程層引擎架構圖

圖7 Arm ML處理器可編程層引擎架構圖

資料來源:Arm

神經網路技術不斷往前推進,在此之中,可看到神經網路有很多不同運算節點,而這些節點也不斷發生變化,作為一款專用機器學習處理器,必須做到可編程性,才能保障自己在機器學習、AI領域的可用性。Bratt指出,該公司ML專用晶片,利用Cortex-M系列可編程技術,打造可編程層引擎,同時加上Vector ISA Extensions與NN ISA Extensions,提供更加靈活的設計彈性,滿足非常多種類型的應用負載。

高階行動裝置領域的另一個重點,則是在由CPU與GPU運行的Android NN類神經網路軟體中,為開發者拓展新目標,同時讓開發者透過次世代處理器與Arm Project Trillium的技術,發揮機器學習運算效能,讓開發者充分運用高效的運算力,將運算任務轉移到終端。這種支援機器學習的裝置,代表無論是在沒有Wi-Fi訊號的地下鐵車廂裡,或是在管制上網的區域,皆能使用Google翻譯、以及影像辨識等諸多功能,而無須連上雲端。

然而,上述的願景都僅只是個開端,隨著5G革命到來,物聯網與人工智慧生態系統正著手顛覆行動的定義,扭轉整個行動產業創新推動的重點與方式,從小螢幕一路涵蓋到大螢幕裝置,Arm讓搭載不同作業系統的手機、平板、以及PC,一同改變人類生活、工作、娛樂、以及學習的方式,讓這些平台透過5G無縫連結,提升更高層次的使用者體驗與便利的生活。