在美國,E-911法規仍是推動全球衛星定位系統(Global Positioning System, GPS)成長的主要催化劑之一。在歐洲地區,利用GPS技術提供手機定址服務(Location Based Service, LBS)將是手機的另一項殺手級應用(Killer Application),具GPS功能的智慧型手機(Smart Phone)將是未來三年成長最快的GPS市場。雖然GPS結合手機的市場具有美好的前景,但這項技術在過去始終存在著一些技術瓶頸待克服。本文將介紹手機和GPS接收機整合的設計考量及所可能面臨的挑戰。

手機/GPS接收器頻率源共享可能引起頻率飄移問題

一般來說,GPS接收器和手機皆須利用振盪器(Oscillator)來提供運算時所需的參考頻率源。而從慣例上看,GPS接收器所使用的參考頻率源為溫度補償石英振盪器(Temperature Compensated Crystal Oscillator, TCXO)並調校至16.368MHz的頻率,不同的解決方案會有不同的頻率值,但大部分都是在16.368MHz附近。手機所使用的參考頻率源則是電壓控制溫度補償石英振盪器(Voltage Controlled Temperature Compensated Crystal Oscillator, VCTCXO),出廠時GSM/GPRS/ EDGE/WCDMA/HSDPA等頻率值會調校至26MHz;CDMA2000/CDMA2000 1xEV-DO為19.2MHz。GPS接收器對參考頻率源通常要求具有較高的頻率穩定,因此大部分的GPS接收器都會配置誤差範圍僅為0.5PPM的TCXO。一般來說,0.5PPM的TCXO其單價約為1.3~1.5美元。由於TCXO的高成本和頻率的不可調性(Untunable),因此並不適用於行動通訊裝置。

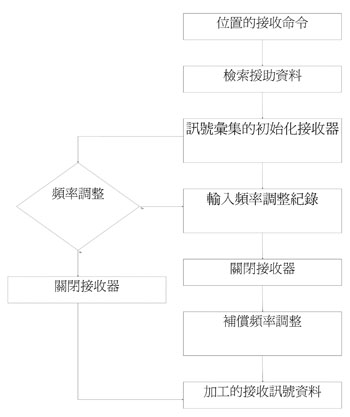

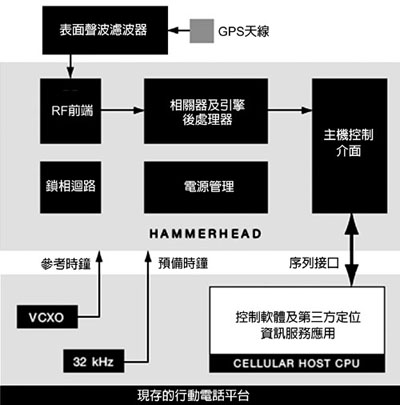

為降低行動通訊裝置整合GPS接收器的硬體成本,由瑟孚(SiRF)擁有的美國專利第6724342號提出一種架構(圖1),利用此種架構可以將GSM手機和GPS接收器共用一個頻率源,即13MHz的VCTCXO。

|

| 圖1 美國專利第6724342揭示的發明 |

上述美國專利案揭示的行動通訊裝置中,若手機接收器電路在GPS接收器擷取(Acquire)/追蹤(Tracking)衛星訊號的期間內調整共用振盪器的輸出頻率,GPS接收器無法立刻得知該振盪器輸出頻率的變化,故容易發生如定位點突然偏離先前位置的定位錯誤。解決問題的方式之一,是在GPS接收器擷取衛星定位訊號的期間內,控制共用振盪器使其輸出頻率維持不變,這種解決方式可能導致該行動通訊裝置的斷話率(Call Drop Rate)大幅提升,因而降低整體的通話品質。

由於GPS接收器對參考頻率源的準確性和頻率漂移(Frequency Drift)相當敏感,實現頻率源共享時仍有些問題須克服。不管手機處於待機(Idle Mode)或通話模式(Active Mode),有四項參數包括相位雜訊(Phase Noise)、頻率精確度(Frequency Accuracy)、頻率飄移、輔助資訊的複雜度等必須列入設計考量,以提升GPS接收器定位的精確度。

在第三代夥伴計畫(3GPP)TS25.101中規範用戶裝置(User Equipment, UE)所發射的調變載波的中心頻率和從基地台所接收到的載波中心頻率的誤差必須小於±0.1PPM。3G手機的上傳和下傳頻率是在2GHz的頻段附近,因此±0.1PPM的誤差代表著載波頻率的誤差必須小於±200Hz,而以26MHz的參考頻率而言,VCTCXO的頻率誤差必須小於±2.6Hz。

相較於基地台中所使用的振盪器,通常行動通訊裝置中所使用的振盪器成本較低但精確度也相對較低,約為±10PPM。由於振盪器的精確度並不如基地台使用的振盪器理想,故其輸出之時脈訊號的頻率會有偏差。這樣的頻率偏差若不加以校正,可能影響行動通訊電路的接收效能惡化,而導致行動通訊裝置與基地台間的通訊無法順利進行。因此,在細胞搜尋(Cell Search)的過程中,行動通訊裝置的接收器電路會對振盪器進行校正,以使振盪器的輸出頻率與基地台所使用的振盪器同步。

大部分的GPS演算法都是基於16.368MHz的參考頻率源,跟主要手機系統的參考頻率並不相同。為達到參考頻率源的共享,GPS接收器的射頻(RF)部分必須將傳統Inter-N形式的鎖相迴路(Phase Lock Loop, PLL)改成Fractional-N PLL,以維持內部的參考頻率固定在16.3680MHz。

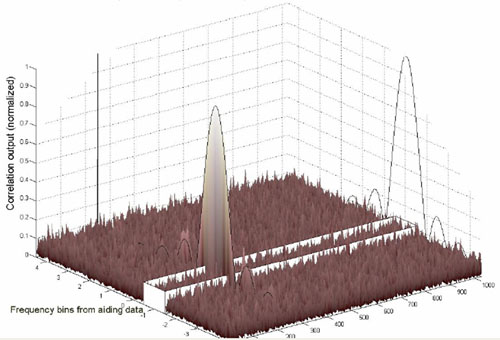

若能克服上述的頻率飄移問題,GPS接收器和手機共享相同的頻率源對GPS本身而言是一項大利多。除可省去昂貴的TCXO外,利用精確的手機參考頻率可降低在頻域(Frequency Domain)的搜尋空間(Search Window),因此即使是在冷開機(Cold Start)/暖開機(Warm Start)時,GPS接收器仍可在很短的時間內擷取衛星的訊號。圖2所示為GPS接收器在頻域的搜尋架構。

|

| 圖2 GPS接收器在頻域和碼域的搜尋架構 |

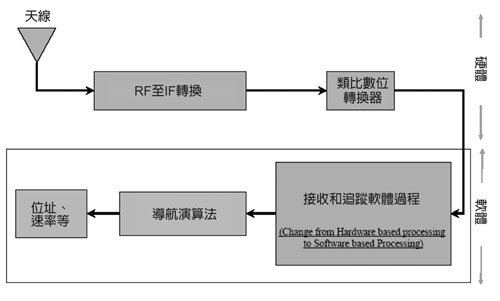

軟體GPS接收器加速衛星訊號重新擷取

傳統GPS接收器中,擷取和追蹤都是利用硬體的方式來實現。現代的GPS接收器設計傾向採用軟體無線電的概念(Software Defined Radio, SDR),所謂的軟體無線電的觀念就是將類比數位轉換器(ADC)在整個射頻鏈路(RF Chain)中的位置盡可能的靠近天線端。只要訊號被數位化後,就可使用功能強大的數位訊號處理器(DSP)和CPU取代部分的硬體功能。而所謂的軟體GPS(Software GPS)就是利用軟體的方式實現衛星訊號的擷取和追蹤,圖3所示為軟體GPS接收器的架構。

|

| 圖3 軟體GPS接收器的架構圖 |

GPS的基頻訊號處理既是數位多位元訊號處理,當然可全部以純軟體的方式透過CPU執行,因此可省略作為相關器(Correlator)的特殊應用積體電路(ASIC)。所有的GPS訊號都隱身在相同的訊號中,記錄一段訊號也就記錄所有衛星訊號,對於不同衛星的搜尋鎖碼便可利用此段訊號,如果CPU執行速度很快,處理不同展頻碼相位(Code Phase)匹配相關的結果,可能要較硬體分時尋找來得快。一般而言,軟體GPS接收器在出隧道之後的訊號重新擷取(Re-acquisition)會比傳統的硬體接收器快,主要因為一般硬體接收器所內建的CPU通常為ARM7 TDMI等級,而應用在軟體接收器的智慧型手機通常內建ARM9等級以上的CPU。因此在重新擷取的條件下,軟體接收器會優於傳統的硬體接收器。

軟體GPS的問題除了要求CPU大量工作外,恐怕無法即時(Real Time)接收衛星資料,而進一步得到精確定位或解算速度,但如果記錄長度夠長還是可算出速度。軟體GPS接收器需要運算功能強大的CPU,因此較適合用在智慧型手機上,截至目前為止,功率和每秒百萬指令(MIPS)的消耗仍是設計上的瓶頸。

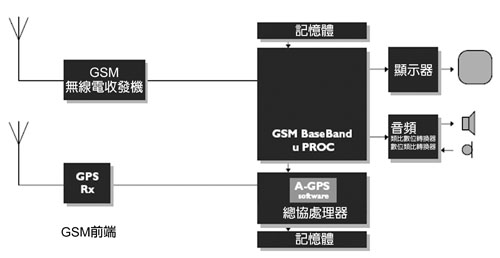

目前市面上主要有兩種軟體GPS接收器的架構,其一為Pure Software GPS Receiver,恩智浦(NXP)的解決方案即是屬於此種架構(圖4)。該架構在硬體方面較為簡單,只須外掛一顆RF IC,將接收到的GPS RF訊號經過RF前級處理、降頻、類比轉數位後,轉換成數位中頻訊號,經由數位介面連結至主機(Host)CPU進行進一步的訊號處理。恩智浦將傳統上採用硬體方式的擷取和追蹤部分變成軟體,並利用Host CPU進行運算。

|

| 圖4 恩智浦軟體GPS的架構及其在AGPS的應用圖 |

另一種軟體GPS接收器架構為Semi-soft GPS Receiver,傳統上硬體式和軟體式的GPS接收器都是以類比至數位轉換器(A/D Converter)作為分水嶺,Semi-Soft則採用折衷方式將數位的相關器及一些控制邏輯電路移到RF IC內,將追蹤電路變成軟體法,並藉由Host CPU進行追蹤和定位運算,Global Locate(GL)即是採用此種架構。由於RF IC採互補式金屬氧化物半導體(CMOS)製程,因此可將數位相關器、控制邏輯和RF IC做成相同晶圓(Die)的晶片以減少成本,另外也可省卻一顆一般為ARM7 TDMI的CPU費用。圖5所示為GL Semi-Soft GPS接收器的架構。

|

| 圖5 GL Semi-Soft GPS接收器的架構 |

手機干擾訊號降低GPS接收器靈敏度

GPS接收器和手機整合最容易遭受的問題便是來自手機的干擾訊號導致GPS接收器的靈敏度和C/N值的降低。要將GPS接收器和手機系統整合在一個有限的印刷電路板(PCB)上,手機電路和GPS接收器間的隔離效果有限,進而造成GPS接收品質的降低。干擾源可區分為系統內(Intra-system)和系統間(Inter-system)兩種形式。系統間干擾途徑主要是透過空中介面(Air Interface);系統內的干擾途徑主要是透過VCC和GND平面的雜訊輻射出來,經由GPS接收天線接收而造成C/N值的降低。表1為系統間和系統內屬性和干擾途徑。

| 表1 GPS系統間和系統內的屬性和干擾途徑 |

| 隔離 |

耦合 |

C/N退化 |

| 系統間 |

空中介面 |

雜訊發射、混附發射、互調失真、鈍化 |

| 系統內 |

合成器、VCC雜訊、GND雜訊、輻射 |

LO洩漏、副波、雜訊耦合 |

一般而言系統內造成的干擾可透過適當的布線(Layout)技術和在主機板適當位置貼上金屬屏蔽(Shielding Cap)、導電泡棉(Conductive Sponge)和銅箔(Copper Tape)抑制雜訊的輻射。系統間的干擾主要有兩大類:

|

|

| |

一般手機的發射功率可達2dBm以上,在GSM頻段最高發射功率可達33dBm,衛星訊號抵達GPS接收器天線的功率不會超過-130dBm。這兩種訊號的功率位準相差甚大,若手機的載波訊號沒有經過適當的衰減即抵達GPS前級的低雜訊放大器(Low Noise Amplifier, LNA)會造成LNA被手機的強訊號飽和(Saturate),而導致GPS接收器C/N值的降低。C/N值的降低和發射機的發射功率、TDMA系統(GSM/ GPRS/EDGE)的工作週期(Duty Cycle)、操作頻段等因素有關,其中發射機的發射功率為U.S. Cellular/GSM頻段:Max. 33dBm,DCS/PCS 頻段:Max. 30dBm,IMT-2000頻段:Max. 24dBm,表2所示為GSM/GPRS Multi-timeslot表,理論上GPRS最多可以同時擁有四個上傳時槽,即50%工作週期,但在一般網路環境中上傳方向最多只支援到兩個時槽,即25%工作週期。比起寬頻多碼分工接取系統(WCDMA)和CDMA2000系統而言,由於GSM/GPRS採用TDMA,因此干擾的問題比較不嚴重,就TDMA系統來說,理論上工作週期愈高GPS C/N值降低愈多。

影響C/N值的降低的值還有操作頻段,包括GSM 850頻段(aka. US Cellular Band),上傳頻段為824M~849MHz,下傳頻段為869M~894MHz;Extended GSM 900頻段(aka. E-GSM頻段),上傳頻段為880M~915MHz,下傳頻段為925M~960MHz;DCS 1,800頻段,上傳頻段為1,710M~1,785MHz,下傳頻段為1,805M~1,880MHz;PCS 1,900頻段,上傳頻段為1,850M~1,910MHz,下傳頻段1,930M~1,990MHz。

GPS的操作頻率為1,575.42MHz,因此當手機在DCS頻段操作時會對GPS接收器的C/N值造成最大影響。理論上當手機在DCS Band的最低頻道且發射功率亦為最大時,會造成GPS接收器有最大的C/N值降低,因此一般評估手機對GPS接收器所造成的C/N值降低的影響,都會利用上述的無線電組態(Radio Configuration)評估。

一般而言,天線具有頻率的選擇性,因此GPS天線本身會對手機頻段造成頻率選擇而產生20~30dB的衰減。為了對GPS接收器的影響降至最低,在設計時會將GPS天線的位置盡可能遠離手機天線的位置,利用空間所產生的隔離效果進一步將影響降至最低。

標準GPS接收器RF前級的架構通常為LNA+SAW,亦即訊號先經過LNA放大後,再經由SAW濾波器濾掉GPS頻段外的雜訊。當GPS接收器和手機整合時,GPS接收器的RF前級一般會採用SAW+RF+SAW的架構,訊號先經由一個SAW濾波器將高功率的手機載波降至可接受的準位後,再經過LNA的處理,以避免LNA被高功率的手機載波給飽和,導致嚴重的C/N值降低。但此種架構會導致GPS的靈敏度降低,主要是因為SAW濾波器本身會有插入損失(Insertion Loss, IL),一般IL的值為0.5~2.5dB,微弱的GPS訊號在未經LNA放大前就被LNA衰減而導致接收靈敏度的降低。

| 表2 GPRS Multi-timeslot表 |

| 位置表 |

最大時間位置 |

容量(kbit/s) |

網路形式 |

| 下傳 |

上傳 |

總數 |

下傳 |

上傳 |

| 1 |

1 |

1 |

2 |

14.4 |

14.4 |

GSM、GPRS |

| 2 |

2 |

1 |

3 |

28.8 |

14.4 |

GPRS |

| 3 |

2 |

2 |

3 |

28.8 |

28.8 |

GPRS |

| 4 |

3 |

1 |

4 |

43.2 |

14.4 |

GPRS |

| 5 |

2 |

2 |

4 |

28.8 |

28.8 |

GPRS |

| 6 |

3 |

2 |

4 |

432 |

28.8 |

GPRS |

| 7 |

3 |

3 |

4 |

43.2 |

43.2 |

GPRS |

| 8 |

4 |

1 |

5 |

57.6 |

14.4 |

GPRS |

| 9 |

3 |

2 |

5 |

43.2 |

28.8 |

GPRS |

| 10 |

4 |

2 |

5 |

57.6 |

28.8 |

GPRS |

| 11 |

4 |

3 |

5 |

57.6 |

43.2 |

GPRS |

| 12 |

4 |

4 |

5 |

57.6 |

57.6 |

GPRS |

|

|

|

| |

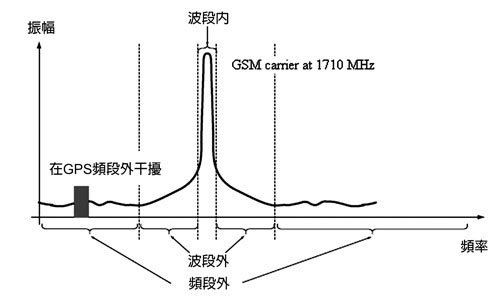

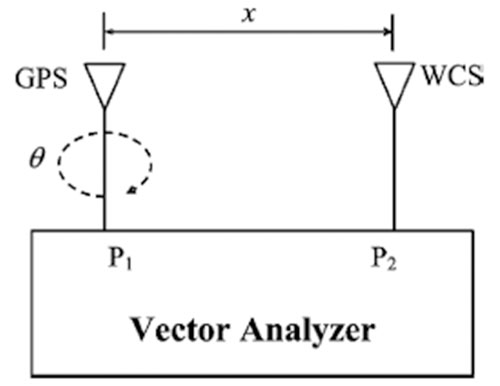

手機頻段外(Out-of-band)的輻射干擾落在GPS頻段內時便造成同頻干擾(In-Band Interference),此時無法藉由任何RF訊號處理將干擾訊號移除。手機頻段外的干擾一般是屬於寬頻的雜訊(Wideband Noise),因此會將GPS頻段的雜訊位準提高進而導致C/N值的降低。GPS接收器C/N值的降低主要受到手機的發射功率、TDMA系統的工作週期、手機收發機內的雙功器(Diplexer)對GPS頻段的抑制效果、手機發射濾波器在GPS頻段的抑制效果、GPS天線對手機頻段的頻率選擇性,即GPS天線和手機天線因空間隔離所產生的隔離效果等因素影響,圖6所示為GSM載波和頻段外的輻射干擾對GPS接收器的影響。圖7所示為GPS天線和手機天線空間隔離效果的量測設定。

|

| 圖6 GSM載波和頻段外的輻射干擾對GPS接收機的影響 |

|

| 圖7 GPS天線和手機天線空間隔離量測的設定 |

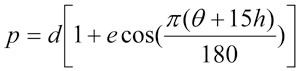

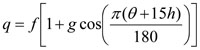

根據圖7的量測設定及公式的假定,可得到以dB為單位量化的空間隔離效果,公式如下:

其中χ為手機天線到GPS天線的距離,θ為螺旋式(Helix)的GPS天線旋轉角,其他係數則整理於表3。根據公式及實際量測的結果可得到包括GPS天線的頻率選擇性約為11dB、在低頻段空間隔離的效果為23dB(900MHz)、在高頻段空間隔離的效果為25dB(1,800MHz)的結論。

| 表3 公式1、2和3的適當係 |

| 係數 |

較低頻率範圍 |

較高頻率範圍 |

| a |

12.6 |

19.6 |

| b |

-39 |

-60 |

| c |

-33 |

33 |

| d |

0.0355 |

0.0135 |

| e |

1.4 |

2.66 |

| f |

-0.031 |

0.019 |

| g |

3 |

1.75 |

| h |

1 |

10 |

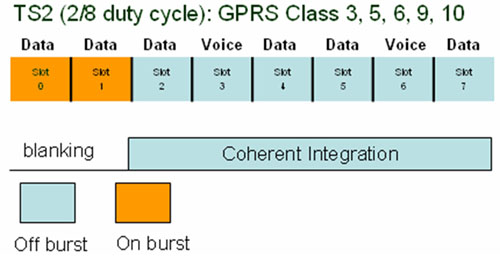

另外,為降低手機發射機對GPS接收器的干擾可以採用訊號遮蔽(Blanking)方式,遮蔽只適用於TDMA系統,CDMA2000和WCDMA則不適用。所謂遮蔽即當手機處於突波中(On Burst)時告知GPS接收器使其遮蔽接收到的訊號,等到手機回復至停止突波(Off Burst)時再將GPS訊號的接收回復正常。利用遮蔽方式可有效的解決手機對GPS接收器的干擾,但是訊號遮蔽會造成GPS接收器訊號同相累加(Coherent Integration)的時間長度受限,導致靈敏度的降低及較長的擷取時間。圖8所示為遮蔽和TDMA系統的關係。

|

| 圖8 遮蔽和GSM ON/OFF Burst的對應關係 |

實務上,GPS基頻晶片可留一個遮蔽的接腳並連接至手機的PA_ON訊號,當手機的發射機準備要發射訊號時,此時PA_ON訊號會被允許,可透過遮蔽接腳告知GPS接收器進行訊號遮蔽動作。當PA_ON失效時,手機也是藉由遮蔽接腳告知GPS接收器可開始進行訊號的同相累加。 |

AGPS毋須透過接收器解算導航資料

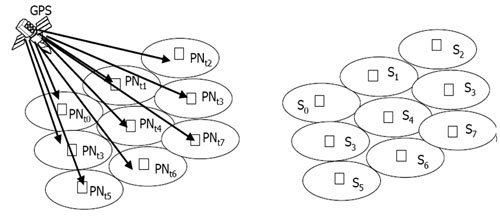

若GPS接收器可不用解算二進位相移鍵控(BPSK)調變的導航資料(Navigation Data),則GPS的靈敏度可大幅提升。在沒有任何輔助資料之下當衛星訊號的強度低於-142dBm時,GPS接收器便很難從雜訊層(Noise Floor)中解算正確的導航資料。但此時Code Phase的量測卻可正確無誤。由於導航資料和用戶位置無關,因此可藉由一個具有良好接收效果的遠端接收器,提供導航資料給用戶端的接收器,而毋須透過接收器本身解算出導航資料,這就是AGPS的基本特色之一。遠端位置伺服器所提供的資料包含Ephemeris係數、Almanac係數、衛星健康資料、衛星時鐘誤差(Clock Error)與大氣層誤差係數(Atmospheric Error Coefficients)等,GPS接收器便可利用輔助資訊將同相累加的時間長度延伸至超過一個導航資料位元的時間,即20毫秒。

無論是歐規GSM陣營(GSM/GPRS/EDGE/W-CDMA/HSDPA)或美規CDMA陣營(CDMAOne/CDMA2000/CDMA2000 1xEV-DO/CDMA2000 1x-EV-DV)都已經針對AGPS訓令制定控制面(Control Plane)的規格和最低性能的規範(Minimum Performance Spec., MPS)。在控制面部分,制定的規格包括CDMA系統之TIA/EIA/IS-801-1、3GPP2 C.S0022-0-1、WCDMA系統的3GPP TS 25.331;MPS部分規格包含TIA 916、3GPP2 C.P9004-0、3GPP TS25.171 V6.0.0。

在有關輔助訊息傳遞的通訊協定和最小性能要求上,這兩大陣營大同小異。較大的不同點在於CDMA陣營裡,手機被要求必須在16秒內回報位置資訊,而GSM則是要求20秒內;另一個主要差異在於精確的時間輔助訊息,由於CDMA系統屬於時間同步系統,基本上各個基地台皆藉由GPS時間來達成精確的時間同步,GSM系統則是屬於非同步的系統(圖9),因此能提供較不準確的時間輔助訊息,也可支援精準的時間輔助但須額外的網路硬體配置,而CDMA系統可提供非常精確的時間輔助訊息,其精準度可小於2微秒。

|

| 圖9 CDMA的同步網路和GSM的非同步網路 |

由於網路架構的不同,在MS-assisted或UE-assisted模式下,CDMA被要求絕對的Code Phase的測試而不是相對Code Phase測試。GSM則被要求依照定義好的演算法進行定位計算的測試。要進行絕對的Code Phase量測須透過行動網路提供精確的輔助時間給AGPS接收器。