現有人機互動的方式,已從傳統利用手持控制器當作輸入,漸漸朝向以人為中心的體感偵測方式。目前市場上亦有讓使用者不需手持控制器,也能達到人機互動操控的體感消費性電子產品(如車用電子、體感遊戲機、智慧電視等)。許多產業界與學研單位在體感偵測技術的研發與創新上可說不遺餘力,創造了許多的應用領域,讓人驚艷不已。

體感系統演進

早期的人機互動主要是透過鍵盤/滑鼠/搖桿等機械或光學裝置達成,後來由於慣性量測元件(Inertial Measurement Unit, IMU)、三軸加速器(Accelerometer)、陀螺儀(Gyroscope)與電子羅盤(Magnetometer)等感測模組的發展,人機互動由單純2D介面操作昇華到可做到包含俯仰(Pitch)、偏擺(Yaw)、翻滾(Roll)等動作的3D感測。而結合光學追蹤系統則能精準有效地做到的360度全方位感測,如任天堂的Wii,採用紅外線影像偵測、加速器與陀螺儀等裝置,感知使用者的揮動、翻轉等動作,開啟運動遊戲類的新玩法;索尼(Sony)的PlayStation Move,採用陀螺儀、加速度計與PS Eye追蹤搖桿上的光球,推出許多經典動作遊戲。而微軟(Microsoft)的XBox Kinect,捨棄傳統感測模組,採用3D深度感測器、可見光(RGB)相機、多麥克風陣列等技術,發展可一比一感知使用者骨架姿態的技術,企圖擴大體感遊戲的可能性,這些都屬於體感技術商品化成功的案例。

新一代的體感系統已逐漸從配戴多個感測器的方式轉變成非接觸式三維感測模式,可以更輕鬆、自然、無束縛的感受體感系統帶給使用者的樂趣與幫助,其中「非接觸式3D感測技術」的突破性發展已成為關鍵焦點。

新一代體感互動核心 非接觸式3D感測技術當道

在3D感測技術尚未問世之前,影像式體感辨識技術都以2D影像為主,但由於2D影像僅有色彩資訊,辨識目標時容易受到環境光線與背景干擾,辨識準確率不足,使得體感辨識產品因使用者體驗不佳而無法普及。直到非接觸式3D感測技術的出現,由於3D影像資訊可感知目標物距離,不會受到背景干擾,才使得近年來新一代體感相關應用技術蓬勃發展。

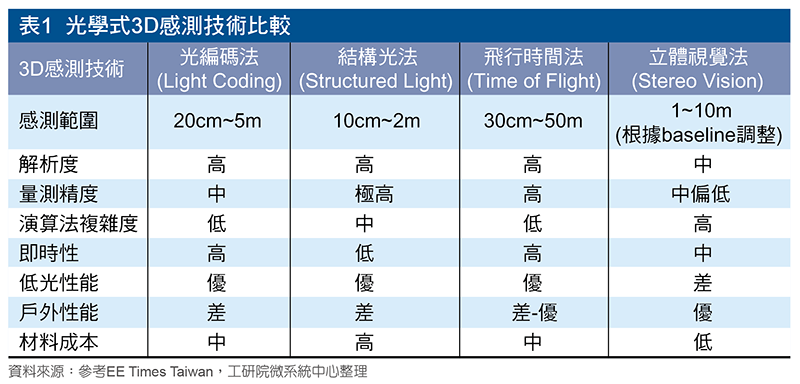

目前非接觸式3D感測技術大多採用光學方式,較為常見的方法有「光編碼法」(Light Coding)、「結構光法」(Structured Light)、「飛行時間法」(Time of Flight, ToF)與「立體視覺法」(Stereo Vision)四種。

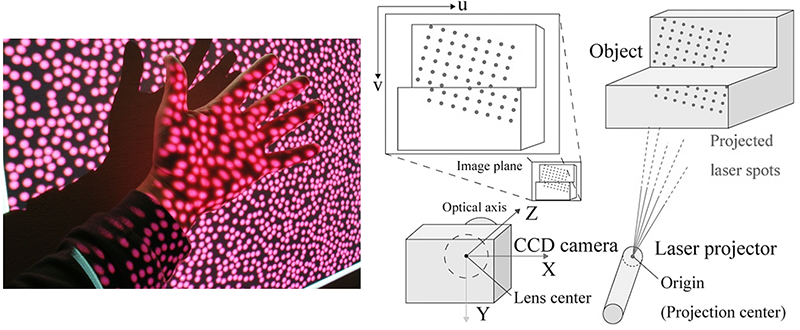

光編碼法是微軟第一代Kinect所使用的深度測量方法,採用的是一家以色列廠商PrimeSense的技術,如圖1所示。光編碼法原理是用特殊編碼過的光源照射場景(給需要測量的空間編碼),屬於結構光技術的一種,只是深度計算方式不同,與結構光法的差異點是,光編碼法的光源稱為雷射散斑(Laser Speckle),是由光照射到物體後隨機形成的衍射斑點。這些散斑具有高度隨機性,空間中任意兩處的散斑圖案皆不盡相同,且會隨著距離的不同而變換圖案。把一個物體放進此空間,只要觀看物體上面的散斑圖案,即可得知此物體距發射源的距離。但須先做一次事前光源標定流程,將整個空間的散斑圖案都記錄下來後方能使用。設備上需有紅外線(IR)相機模組、RGB相機模組與IR發射器。光編碼法只需要普通的CMOS感光晶片即可運作,較飛行時間、結構光技術的限制少,這特點可讓整體方案的成本大大降低。同時光編碼技術的測量精度只與標定時取得的參考面密度有關,與空間幾何無關,而傳統結構光方法採用三角空間幾何視差測距,基線長度(Base-line)(光源與鏡頭中心的距離)越長精度越高,但會增加整體裝置尺寸,而光編碼法則不用為了提高精度而將基線拉寬(增加裝置體積)。

圖1 光編碼法

圖1 光編碼法

資料來源:日本應用物理學會(JSAP)

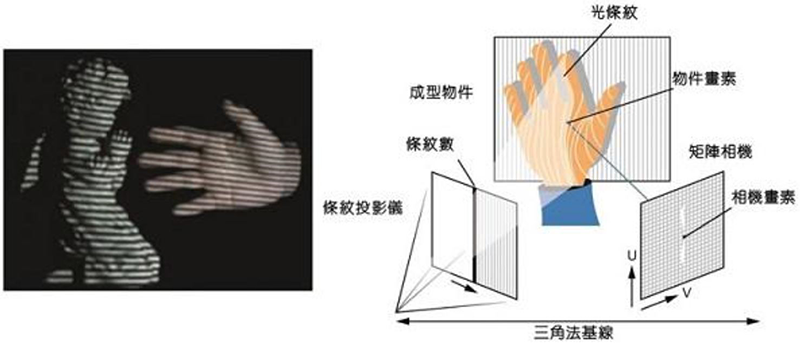

結構光法硬體需包含IR發射器、IR相機模組與RGB相機模組,原理是對目標打出條紋光,再透過打出去的光紋變化與原始條紋光比較,利用三角原理計算出物體的三維座標,如圖2所示。結構光法實現簡單且精度較高,所以應用非常廣泛,較常應用於工業檢測和研究用途。

圖2 結構光法

圖2 結構光法

資料來源:University of Kentucky、Laser Focus World

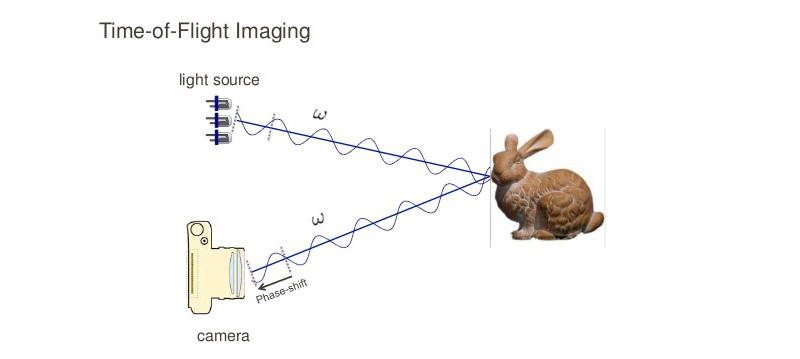

飛行時間法是微軟併購的3DV Systems所開發的技術,也是第二代Kinect採用的技術。飛行時間法的原理是透過IR雷射發射到場景中,記錄每一點光脈衝往返觀測點的時間,進而推算出觀測點距發射端的距離,並擴展光脈衝由點到面,以得出3D景深圖,如圖3所示。系統需IR發射器和接收器,並配合相機模組和感光元件或感應陣列。

圖3 飛行時間法

圖3 飛行時間法

資料來源:Stanford Computational Imaging

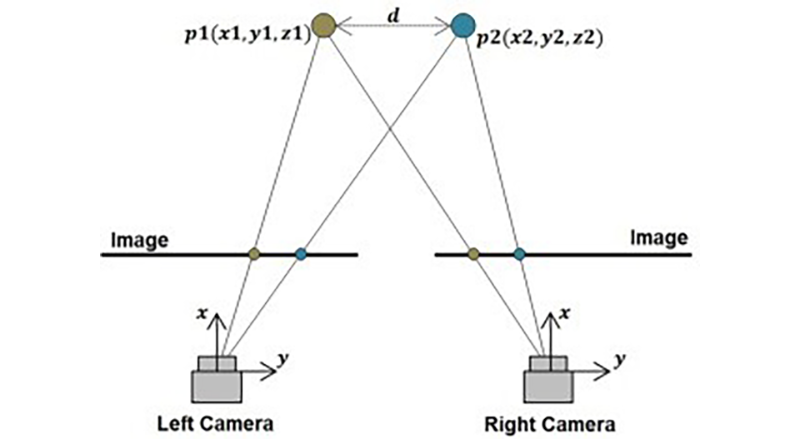

立體視覺法是透過兩個相機模組拍攝影像,架構如圖4,只需RGB相機模組而不用IR模組的技術,利用模擬人類用雙眼感知距離的原理,透過兩個相機模組擷取目標物影像,進行三角測量等運算以取得物體與攝影機的距離。由於立體視覺法需進行較複雜的影像運算,通常需要一個額外的影像運算晶片輔助,國內晶片廠鈺創已開發出立體視覺運算晶片產品。

圖4 立體視覺法

圖4 立體視覺法

資料來源:ScienceDirect

四種光學式3D感測技術的比較結果如表1。立體視覺法和結構光法都需圖像分析運算,但立體視覺法的軟體演算法較為繁雜,且偵測較遠距離時,鏡頭間的基線長度也得拉長,造成系統尺寸增大,在應用上需要在解析度與即時性有所取捨。相對地,光編碼法轉換各區域散斑來計算距離,飛行時間法也只需記錄每個觀測點的時間數據後再進行計算,相對複雜度較低。但這兩項技術均需IR發射和接收器,也會需要額外記憶體,甚至是運算元件,成本相對較高。另外,因為兩者的細部運算原理不同,光編碼法是將整個畫面進行切割測距,要得到概略的深度圖較為容易;飛行時間法單點IR只需記錄時間,理論上會比光編碼法,先分析散斑圖形再運算來得更為簡易。整體而言,在要求即時性下,飛行時間法的反應速度和精確度最佳,光編碼法在不需要精細景深圖的整體表現較為均衡,立體視覺法的成本最低,而結構光法則是在不要求即時性,且短距使用下,可獲得最高解析度與精確度。

3D肢體手勢辨識技術應用百花開

在3D感測中具有突破性應用就非微軟推出的Kinect莫屬,最令人驚艷的是不需要穿戴任何裝置即可與遊戲做互動,使用者的肢體動作即是控制器,重新定義了人類與機器的互動方式。微軟所推出的Kinect遊戲機,標榜無須穿戴或手持控制器,而是利用語音指令結合其獨特的人體骨架辨識技術,即可捕抓使用者的全身上下動作,主打「免控制器的遊戲與娛樂體驗」。人們不需要穿戴任何的感測裝置即可體驗遊戲、操作介面,一股非接觸式的3D體感互動模式興起。而微軟亦推出適用於Windows系統的Kinect版本「Kinect for Windows」,企圖藉由作業系統Windows的普及,將非接觸的體感互動從遊戲體驗帶入教育、商用等領域,之後更多體感應用的裝置與新創公司則如雨後春筍般的出現。

隨著體感互動應用的興起,如何識別使用者的姿態動作、手部位置與手勢等資訊,在體感應用中也顯得越來越重要,各大科技大廠與新創公司爭相推出其手視互動的裝置與技術。

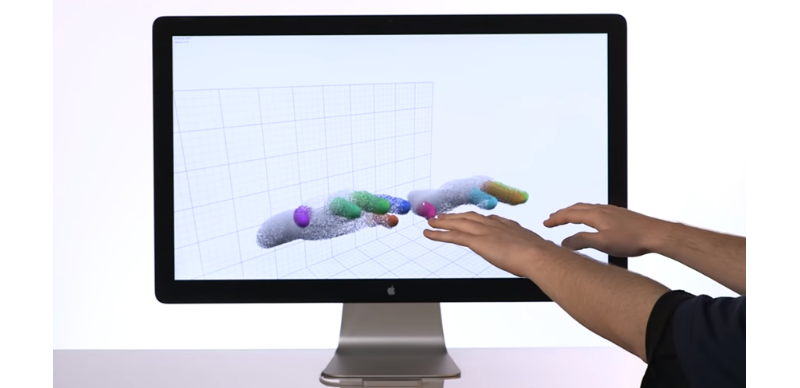

如新創軟體公司Leap Motion(如圖5)、凌感科技則各自推出可追蹤與識別手部動作的裝置並提供軟體開發套件(Software Development Kit, SDK),提供多媒體開發商,發展體感互動應用;台灣酷手科技則推出穿戴式手勢輸入裝置(如圖6),透過表面肌電圖(surface Electromyography, sEMG),分析手勢動作。

圖5 Leap Motion手勢辨識裝置

圖5 Leap Motion手勢辨識裝置

資料來源:Leap Motion YouTube官方頻道

圖6 酷手科技穿戴式手勢輸入裝置

圖6 酷手科技穿戴式手勢輸入裝置

資料來源:酷手科技

體感互動技術持續發展,殺手級的體感應用陸續誕生,微軟與宏達電不約而同地推出其VR/MR的體感應用裝置,Hololens與HTC Vive。沉浸式的體感應用裝置,讓使用者感受到身歷其境的視覺體驗效果,而與多媒體內容互動則需要藉由體感偵測的技術方可達成,HTC Vive系統採用手持控制器方式的捕捉使用者手部姿態動作,而微軟Hololens則是透過影像感測器凌空判別使用者動作(如圖7),結合AR智慧眼鏡操作應用。然而僅靠手持控制器或裝置上的影像感測器並無法達到全身的體感互動,能夠結合人物動作感測與手部姿態辨識的沉浸式體感技術將是未來研究的主要趨勢。

圖7 Microsoft Hololens

圖7 Microsoft Hololens

資料來源:Microsoft

工研院VR/服務機器人手勢互動技術雙管齊下

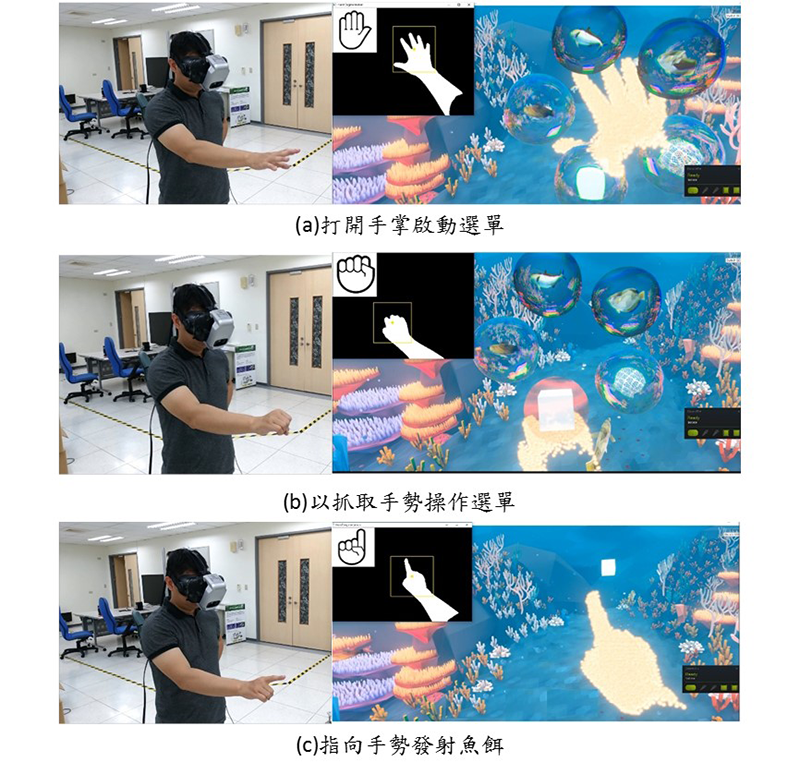

工研院開發的VR 3D手勢操控互動系統,希望透過手勢的操作達到無須穿戴任何手持裝置即可與遊戲互動。藉由開發的多角度手勢認知學習技術,建立不同視角與移動式辨識能力,將自行研發的ToF深度攝影機整併至現有的HTC VIVE裝置上(如圖8),透過ToF攝影機輸入的手勢深度影像來辨識手勢種類以及進行連續動作分析來達到與遊戲互動的功能。手勢操作方面,以打開手掌方式來啟動選單(如圖9a),藉由移動手部位置做選取(如圖9b),並以連續手勢變換動作達到發射魚餌(如圖9c)、魚群、漁網等遊戲互動功能,完成一套手勢辨識技術整合VR顯示裝置的互動遊戲,未來還可導入VR社交遊戲與運動遊戲等應用。

圖8 整合ToF攝影機與HTC Vive頭盔

圖8 整合ToF攝影機與HTC Vive頭盔

圖9 工研院VR手勢辨識互動系統

圖9 工研院VR手勢辨識互動系統

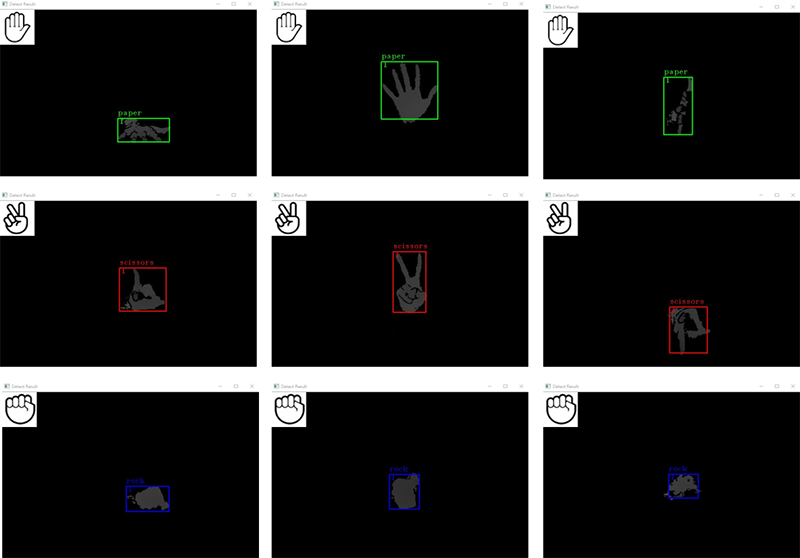

目前市場上的手勢辨識技術,都需要手勢正面完整輪廓才能成功辨識,若角度歪斜或手部翻轉就無法分辨,讓許多產品無法普及應用。工研院研發的3D手勢辨識技術,是以深度學習為核心的深度影像感知建立技術,結合自我學習模型更新機制。利用有限訓練資料庫以模擬的方式,創造出具有差異性的手勢影像資料,增加訓練資料庫資料多樣性以提升任意角度手勢辨識率,並在訓練過程中選取最佳訓練模型。透過輸入的手勢深度影像即能找出正確手勢類別及位置,完成手勢辨識分類與追蹤,克服手勢辨識僅能單一角度辨識的問題,可辨識10種手勢並適應各種3D角度。此技術可應用於服務機器人,以手勢指令操控服務機器或是進行猜拳遊戲,可適應各種3D手勢角度的能力將可提供更好的人機互動體驗(如圖10)。

圖10 工研院開發的手勢辨識技術可適應多種3D角度

圖10 工研院開發的手勢辨識技術可適應多種3D角度

影像辨識推進 體感互動更上層樓

隨著體感互動技術逐漸蓬勃發展,世界大廠不約而同推出VR/AR/MR的體感應用裝置,像是HTC Vive、Oculus Rift、Samsung Gear等,這些沉浸式體感應用裝置,讓使用者不受時間、地點、空間限制,達到身歷其境的視覺體驗效果。然而目前大部分體感互動裝置仍需透過搖桿、穿戴感測器等裝置才能進行互動,讓使用者覺得受拘束,無法進行自由化、直覺化操作。近年來體感互動裝置逐漸加入影像辨識技術,從傳統2D影像辨識,到近年來主流的非接觸式3D感測,其目的無非是想讓機器擁有視覺能力,因人類獲得的資訊80%以上皆由視覺而來,如果機器擁有視覺能力,能即時對影像作出辨識及反應,將使得機器更聰明、更具人性化。人機互動方式也從過去以穿戴式裝置、搖桿等方式,逐漸被更直覺、自然的手勢辨識、肢體辨識操作所取代,能夠結合人物動作感測與手部姿態辨識的沉浸式體感技術將是未來研究的主要趨勢。隨著3D感測技術的提升與AI影像辨識技術的發展,體感互動除了娛樂產業應用外,也開始廣泛導入應用各種載具,如醫療、服務機器人、車用電子,智慧電視,互動廣告看板與博物館導覽等,相信後續市場上將會出現更多令人興奮的體感互動應用創新產品。

(本文作者皆任職於工研院智慧微系統科技中心)

首圖來源:Microsoft