近年來自動駕駛、車聯網與電動車都是這次汽車產業發展的三大主軸。隨著物聯網與車聯網的快速發展,現今汽車工業裡車輛不再只是交通工具,汽車科技的走向變遷迅速,並提倡智慧化、自動化,使車輛結合人工智慧(AI)具備能感知周遭環境、自動駕駛等功能。

根據美國汽車工程師協會(SAE)定義,自駕車從Level 0到Level 5分成六個等級,其中Level 0~Level 2是由駕駛操控車輛,配有程度不同的先進駕駛輔助系統(Advanced Driver Assistance Systems, ADAS),主要是讓車輛在人為的操控下可以提升安全性。而Level 3~Level 5則是進入自駕的範圍,必須要導入人工智慧決策系統。Level 3可以讓車輛短暫接手駕駛,稱為Hands Off;Level 4駕駛就不用再盯著路況,稱做Eyes Off;Level 5進入全自駕,車輛甚至不用安裝方向盤與油門、煞車等人為操駕系統,稱做Minds Off。

不過,目前市面上的車輛自駕功能仍多以Level 2等級或以下為主,Level 2與Level 3最主要的不同在於,Level 3必須在系統控制與駕駛控制模式間轉換,然而目前系統無法在緊急狀況發生時即時反應,是汽車升級到Level 3所要克服的挑戰。目前,自駕車除了須透過硬體優化來提高運算效能,軟體方面也必須有所提升,才能更進一步將汽車自動化等級推向Level 3,甚至是Level 4、Level 5。

本文是基於智慧車載服務系統與應用發展計畫,針對影像式防撞輔助系統來進行汽車與二輪車事故標準情境之規畫設計與實驗,探討四輪車的車用深度攝影機所拍攝之影像效果,以及是否可即時偵測到二輪車的動態,預防事故的發生,並做為發展駕駛安全輔助系統的重要依據。

深度攝影機之探討

以下先介紹何謂深度攝影機,並說明現今的技術有哪些實際應用。

何謂深度攝影機

RealSense是基於立體視覺技術的深度攝影機,其特別之處在於實施由左成像器、右成像器以及可選的紅外訊號發射器組成。工作原理是,紅外發射器發射出紅外散斑,以提高低質感場景中的深度精度,左右兩個紅外相機採集兩張紅外圖像,處理器根據兩張紅外圖像中的散斑特徵點匹配計算視差圖,最終得到深度圖。

本文使用英特爾(Intel)D435深度攝影機,其規格如表1所示,D435是2018年初推出的新款深度攝影機,具有小巧的外型,適用於近距離深度圖像採集,具有較高的圖像分辨率和採樣頻率,適合做多種深度訊息相關的應用開發。D435深度攝影機主要使用英特爾軟體開發工具組2.0(SDK2.0),這是一種開源、跨平台開發套件,支援Windows 10,其中包含工具、代碼、示例和多種語言包裝,用於從深度攝影機中提取資料。

現今技術有何應用

目前深度攝影機主要應用在手機端所使用,隨著iPhone X的推出,大家也更加認識深度攝影機,未來在人臉辨識、手勢操作、人機互動、擴增實境(AR)、虛擬實境(VR)、先進駕駛輔助系統、Level 3以上自動駕駛、無人機以及無人工廠的應用將會更加全面,提升深度攝影機的發展。

深度攝影機有別於一般相機

相較於攝影機將真實世界的三維(3D)空間影像儲存成二維(2D)XY軸的平面畫面,深度攝影機可以測量出每一個影像點和攝影機之間的Z軸距離,儲存的格式為三維空間資訊。

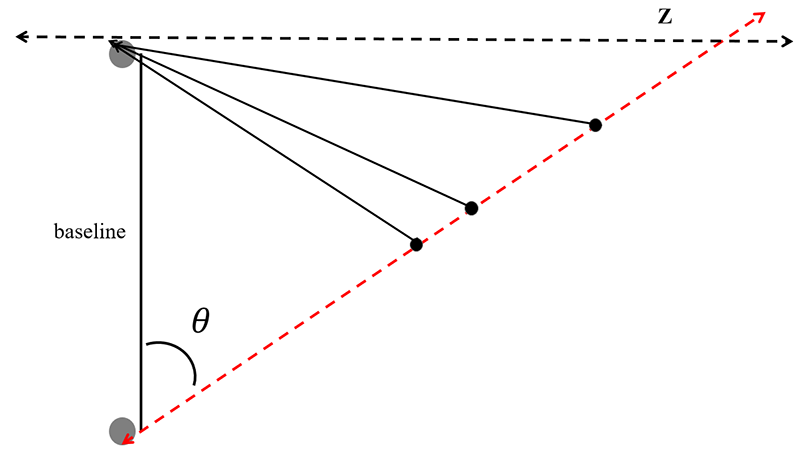

其成像原理為由深度攝影機之兩個鏡頭所擷取影像,用演算法比較兩者的差異後就能得到影像點深度的Z軸資訊(圖1),甚至有一些深度攝影機還會在鏡頭處以紅外線等不可見光源,發射光線到拍攝目標,藉由反射回來的資訊計算各反射點與攝影機之間的距離。

圖1 深度攝影機成像原理示意圖

圖1 深度攝影機成像原理示意圖

多攝影機之影像防撞警示方法說明

以下從傳統攝影鏡頭的限制以及實驗設備兩部分,來說明多攝影機之影像防撞警示方法。

傳統攝影鏡頭的限制

目前國際間所使用的道路安全輔助服務多以四輪車為主,然而,在東南亞、台灣的交通環境中,仍以二輪車為主。

傳統四輪車只有左、右及中間的照後鏡可以讓駕駛在不回頭的情況下看到後面的車況,但在車輛行駛中人的視覺範圍會因速度提升而變窄,二輪車相對於四輪車體積較小,時常遊走在四輪車的死角範圍內,易造成不必要的事故。

藉由增加攝影機數量來彌補前述的死角問題,讓車上的影像處理系統可感知車體四周的車況,讓駕駛安全輔助系統更符合駕駛的開車習性,並進一步提升車輛的安全性。

本文規畫設計6台攝影機的安裝位置,且根據不同的天氣因素、行駛速度、地形等,模擬各種二輪車車禍事故情境,並藉此模擬、測試及收集相關數據及參數,藉由不同視角之拍攝,如駕駛人視角與高空拍攝之全景視角來收集影像資料,作為發展四輪車對二輪車間相關安全輔助系統的基礎。

實驗設備介紹

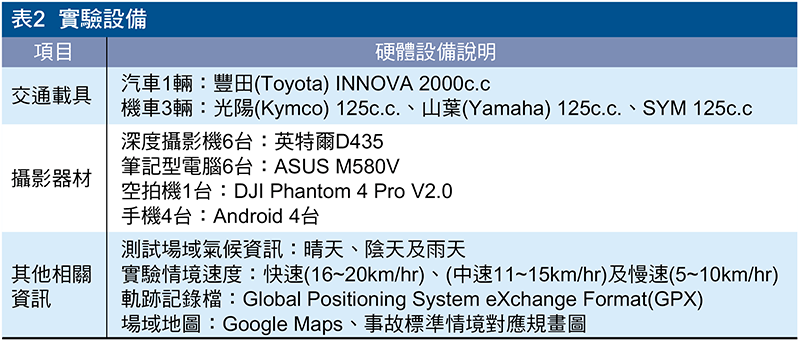

情境模擬所需設備如表2所示,在測試情境中將汽車360度環景畫面進行收錄所需1輛汽車與6台深度攝影機。汽車車上的攝影機架設是採用專用吸盤配件以方便調整位置。

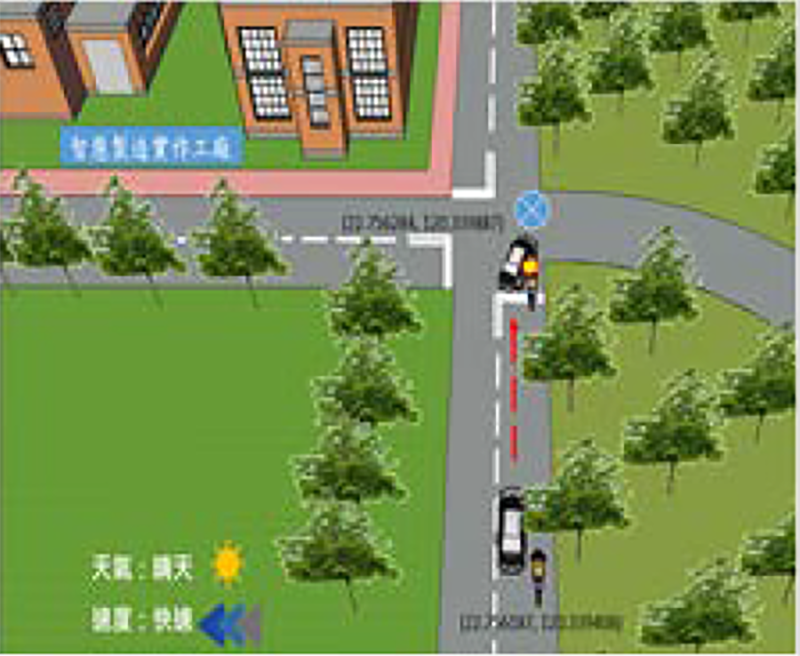

依照事故標準情境規畫,配置1~3輛機車做為輔助,模擬與汽車行駛狀況互動。此外,規畫1台空拍機如圖2中央偏右上方圓圈所示,置於高空位置以俯視的第三視角進行拍攝,來觀測情境中的第三者所看到的四輪車與二輪車的事故過程。

圖2 情境模擬含全球定位座標示意圖

圖2 情境模擬含全球定位座標示意圖

攝影機鏡頭架設組態之規畫設計

研究探討在硬體設備限制條件下,運用6支攝影機並導入深度資訊規畫出拍攝組態,透過視角的覆蓋率計算,趨近零死角的拍攝組態做為目標。

6攝影機安裝位置規畫設計

深度資訊有助於降低演算法複雜度,減少運算時間,對於駕駛安全輔助系統有很大的幫助,本研究提供一種拍攝組態設計。

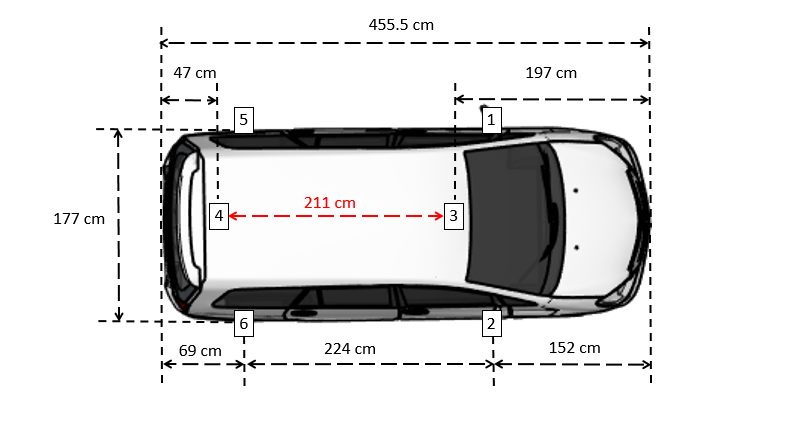

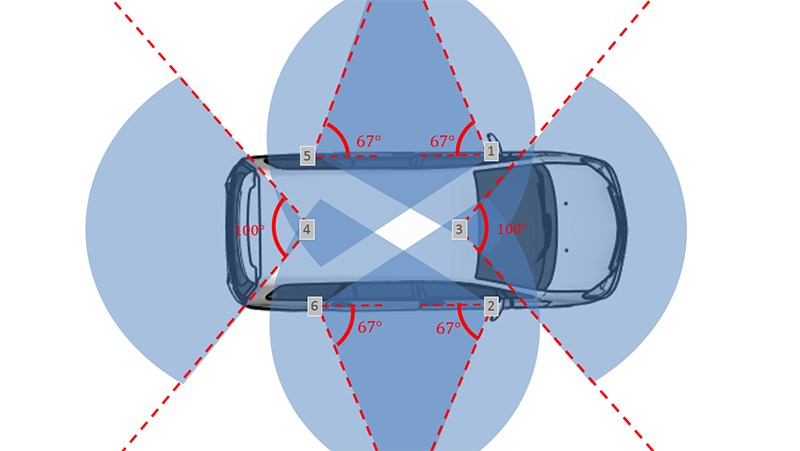

6攝影機組態一

本組態中,攝影機的位置如圖3所示,其中攝影機分別安裝於標示1、2、3、4、5、6的車子上方位置上。架設點1位於左後照鏡,架設點2位於右後照鏡,兩者相距177公分(cm),架設點1與架設點2與車頭相距152公分,架設點3位於車頂,距離車頭中心點197公分,架設點4位於車頂後方,距離車尾中心點47公分,架設點3與架設點4相距211公分,架設點5位於後車廂左方,架設點6位於後車廂右方,兩者相距177公分,架設點5與車尾相距69公分,架設點6與車尾相距69公分。

圖3 六攝影機組態一之影機架設位置圖

圖3 六攝影機組態一之影機架設位置圖

如圖4所示,雖然圖中看起來第3攝影機(前方)與第4攝影機(後方)會有死角,實際上可用第5攝影機(左後)與第6攝影機(右後)補足第3攝影機(前方)的死角問題,則第1攝影機(左前)與第2攝影機(右前)則可補足第4攝影機(後方)的死角問題,此方法並不會有死角產生。

圖4 六攝影機組態一之攝影機拍攝角度

圖4 六攝影機組態一之攝影機拍攝角度

攝影機實際安裝與拍攝測試

根據攝影機鏡頭架設的規畫設計,本文以解析度1,280×720的Intel RealSense D435做為實際的攝影機,攝影雖然有記憶體容量、拍攝時間、成本高於一般行車記錄器等問題,但可運用後製影像處理且容易進行影像分析,所以使用Intel RealSense D435深度攝影機是一個讓拍攝影像可長久使用的實驗方案。以下為組態實際安裝後的實際位置圖,並探討場域實驗後的各種影像效果。

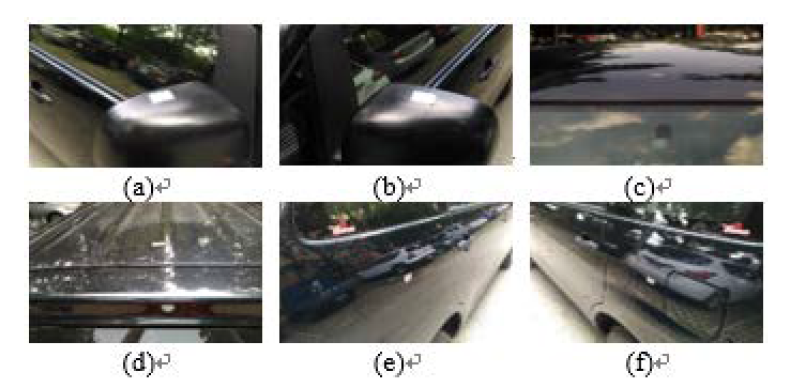

6攝影機組態一

本組態之架設位置分為兩部分,第一部分為車身左側,如圖5所示;第二部分為車身右側,如圖6所示。實體拍攝影像為圖7,圖7(a)為第1攝影機拍攝的左後方影像,圖7(b)為第2攝影機拍攝的右後方影像,圖7(c)為第3攝影機拍攝的前方影像,圖7(d)為第4攝影機拍攝的後方影像,圖7(e)為第5攝影機拍攝的左前方影像、圖7(f)為第6攝影機拍攝的右前方影像。

圖5 六攝影機組態一之實際安裝位置

圖5 六攝影機組態一之實際安裝位置

圖6 車身右側攝影機架設位置

圖6 車身右側攝影機架設位置

圖7 六攝影機組態位置之實際安裝位置。(a)對應圖5之1的位置。(b)對應圖6之2的位置。(c)對應圖5之3的位置。(d)對應圖6之4的位置。(e)對應圖5之5的位置。(f)對應圖6之6的位置。

圖7 六攝影機組態位置之實際安裝位置。(a)對應圖5之1的位置。(b)對應圖6之2的位置。(c)對應圖5之3的位置。(d)對應圖6之4的位置。(e)對應圖5之5的位置。(f)對應圖6之6的位置。

情境拍攝過程與拍攝結果說明

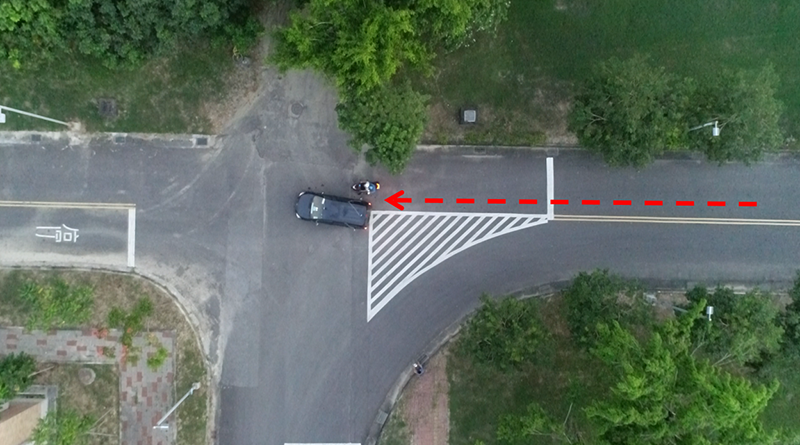

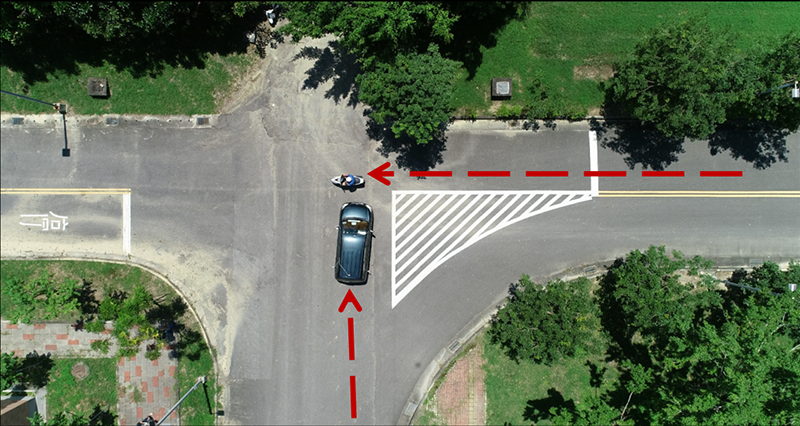

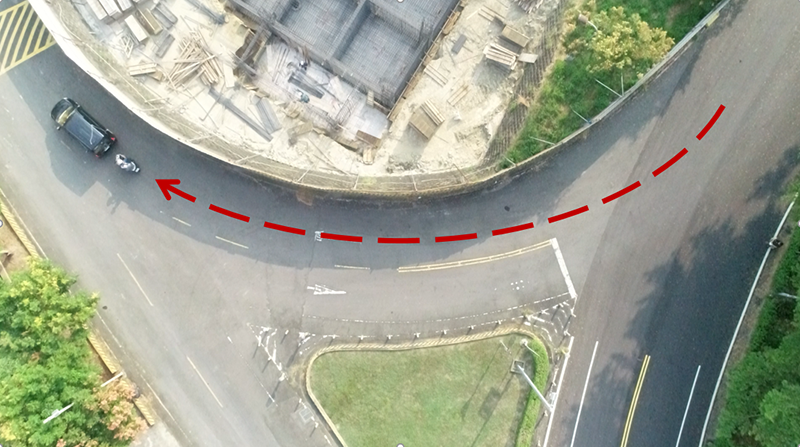

圖8為側撞情境之第三視角,圖中汽車駕駛與機車駕駛,沿道路向前直行,汽車駕駛於十字路口向右轉彎,機車駕駛繼續直行而產生擦撞的事故情境。

圖8 側撞之第三視角俯瞰圖

圖8 側撞之第三視角俯瞰圖

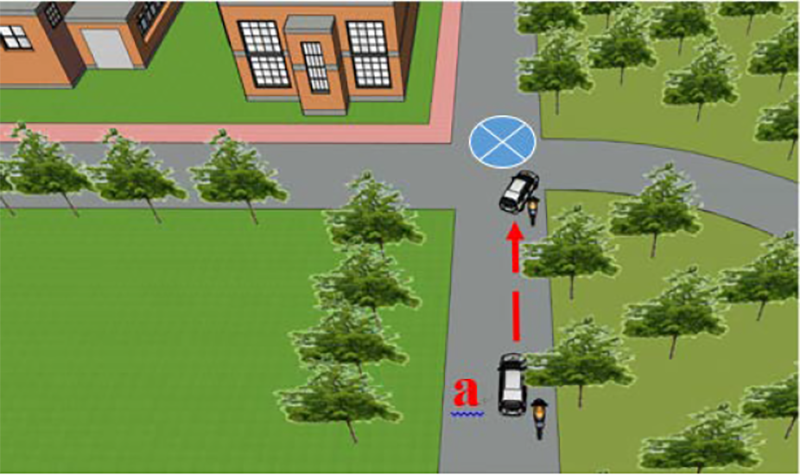

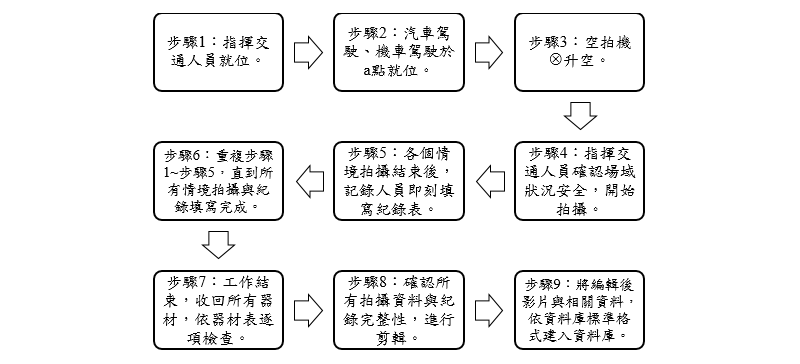

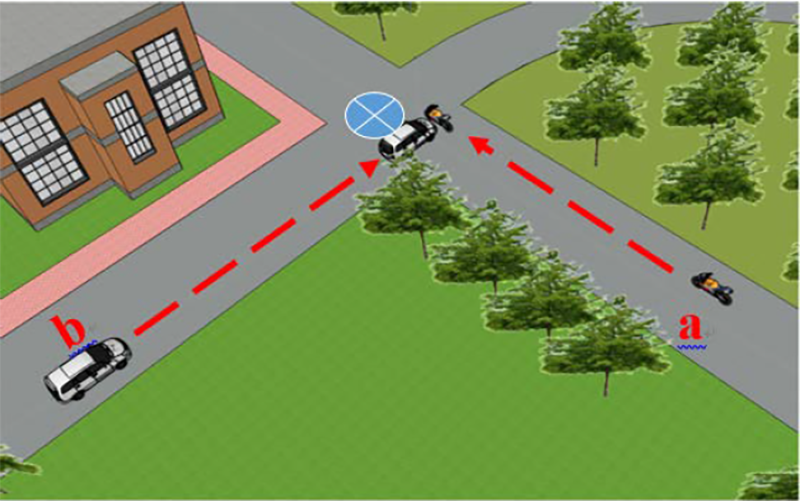

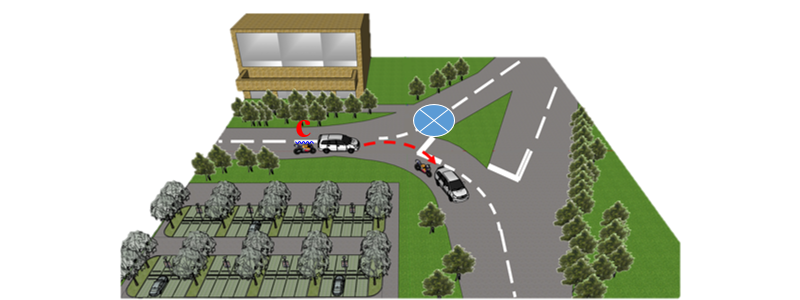

實際情境規畫以圖9側撞事故情境示意圖來說明情境拍攝步驟,如圖10所示。

圖9 側撞事故標準情境示意圖

圖9 側撞事故標準情境示意圖

圖10 側撞事故之標準情境拍攝步驟

圖10 側撞事故之標準情境拍攝步驟

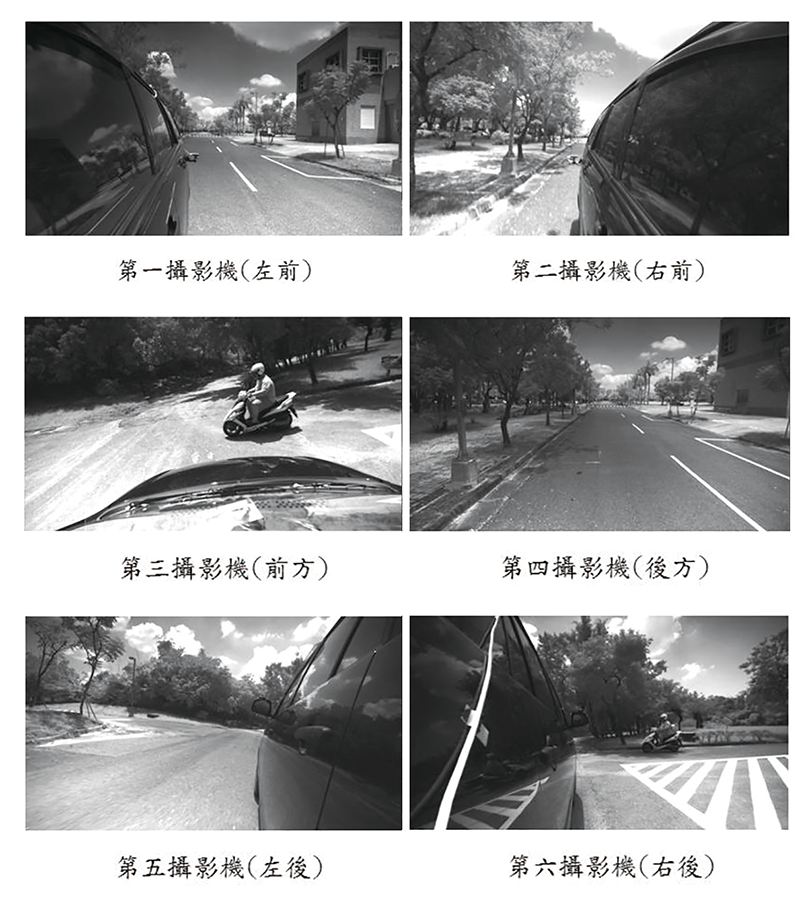

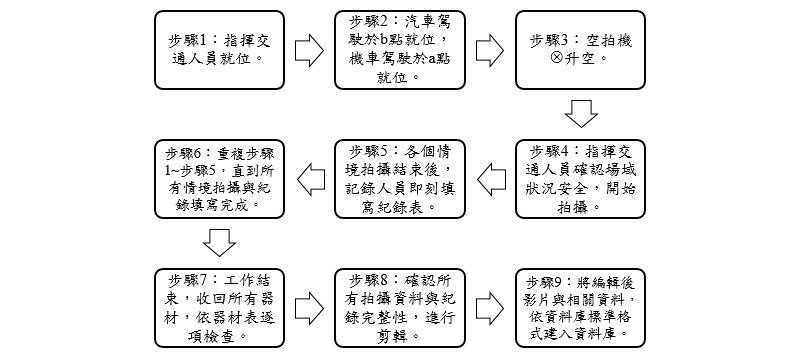

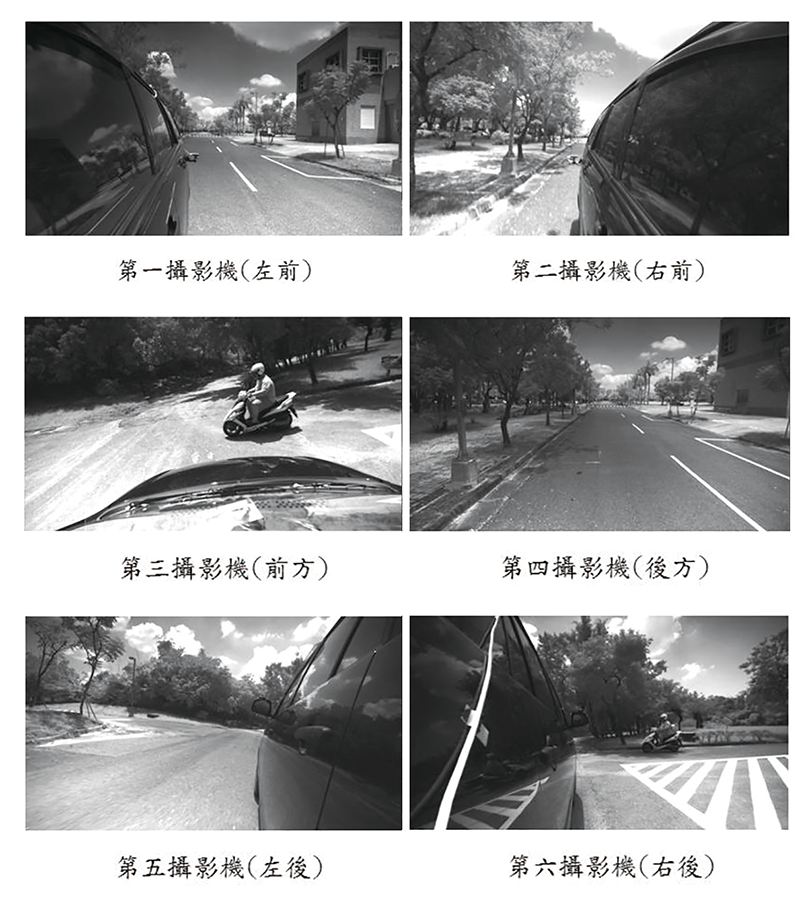

圖11為側撞事故之六個攝影機現場拍攝狀況,一般鏡頭實際拍出的畫面。圖12則為側撞事故之6個攝影機現場拍攝狀況,紅外鏡頭實際拍出的畫面。

圖11 側撞一般鏡頭拍攝畫面

圖11 側撞一般鏡頭拍攝畫面

圖12 側撞紅外鏡頭拍攝畫面

圖12 側撞紅外鏡頭拍攝畫面

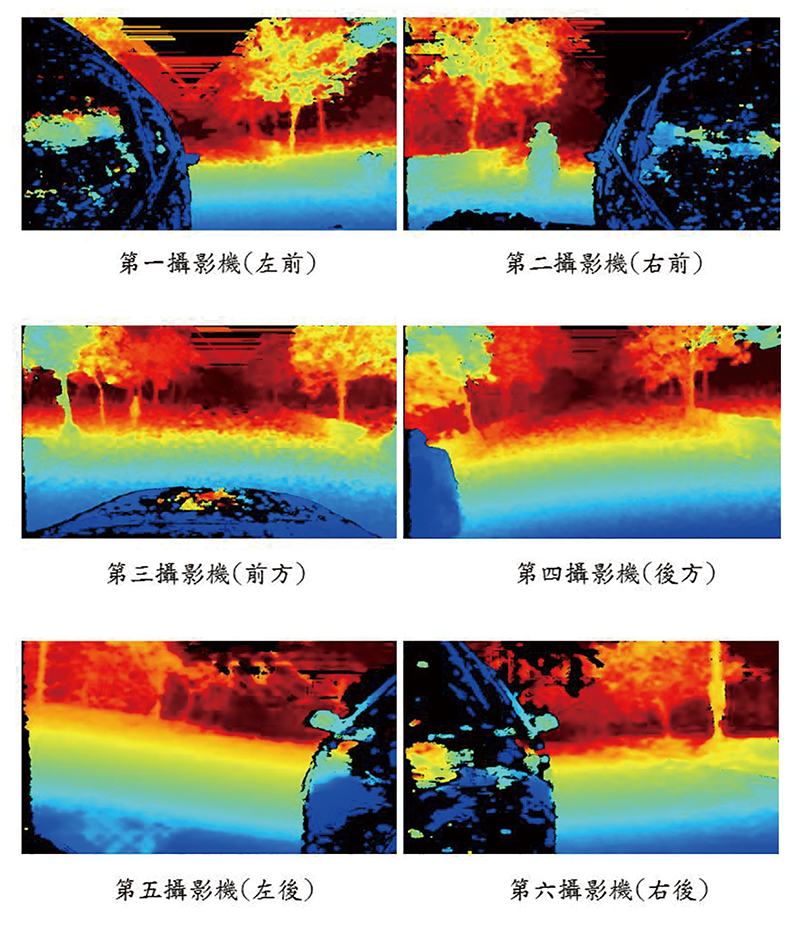

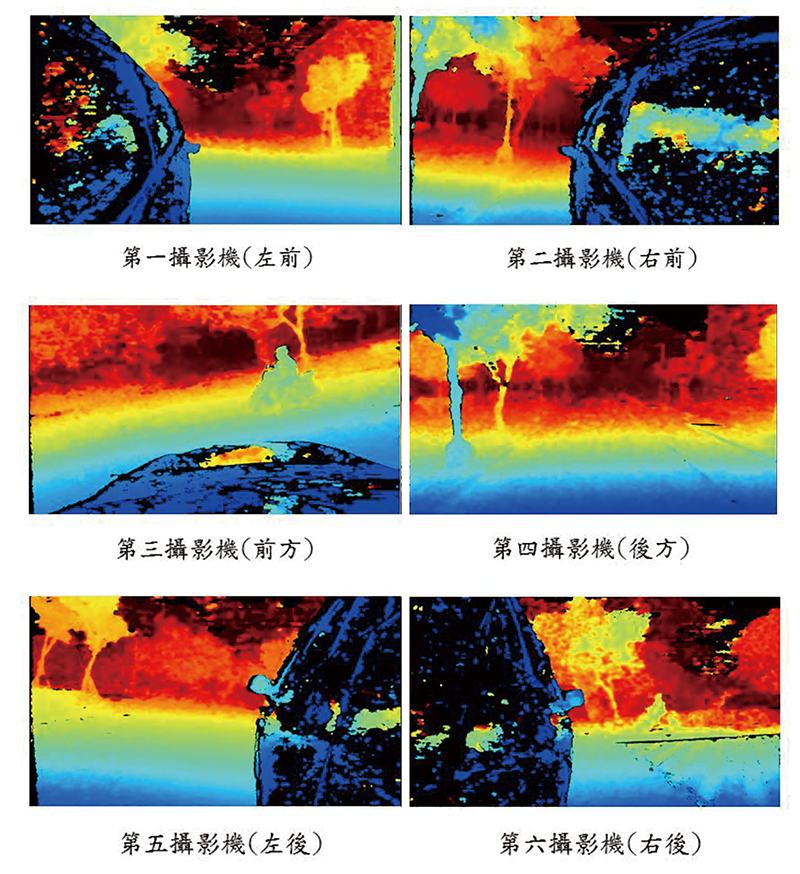

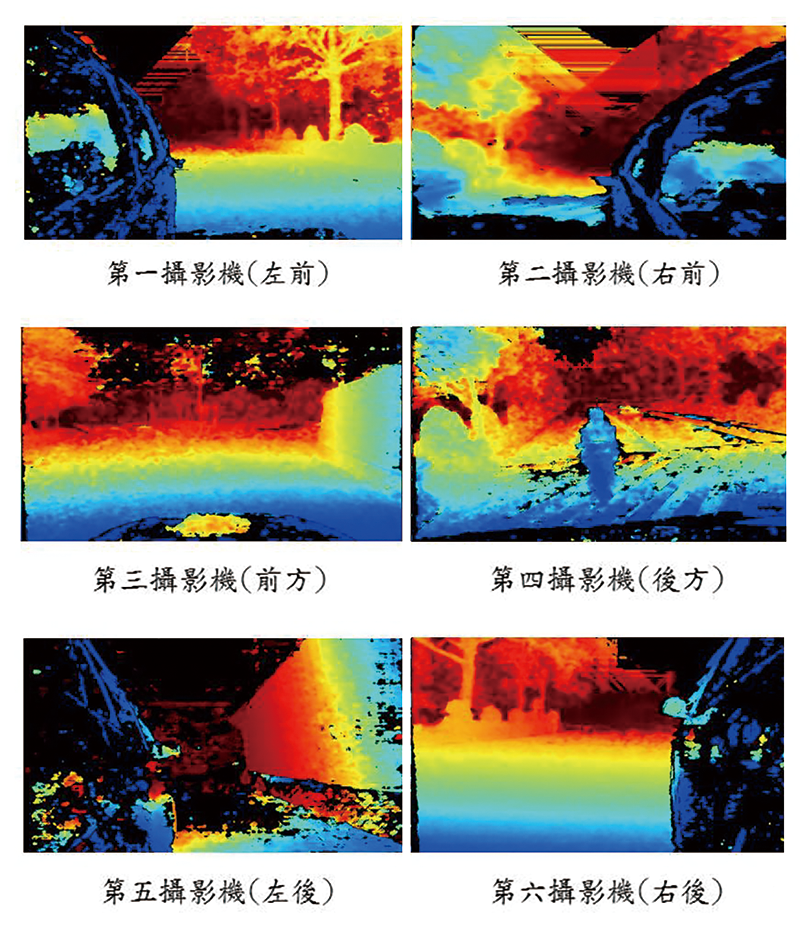

圖13為側撞事故之6台攝影機現場拍攝狀況,帶有深度資訊之鏡頭實際拍出的畫面。而圖14為交叉撞事故情境之第三視角,圖中汽車駕駛與機車駕駛,沿道路向前直行,汽車駕駛與機車駕駛將於十字路口交會,而產生交叉撞的事故情境。

圖13 側撞深度資訊之鏡頭拍攝畫面

圖13 側撞深度資訊之鏡頭拍攝畫面

圖14 交叉撞事故之第三視角

圖14 交叉撞事故之第三視角

圖15所示為交叉撞事故情境示意圖,其情境拍攝步驟說明如圖16所示。

圖15 交叉撞事故標準情境示意圖

圖15 交叉撞事故標準情境示意圖

圖16 交叉撞事故之標準情境拍攝步驟

圖16 交叉撞事故之標準情境拍攝步驟

圖17為交叉撞事故之6台攝影機現場拍攝狀況,一般鏡頭實際拍出的畫面。圖18則是交叉撞事故之6台攝影機現場拍攝狀況,紅外鏡頭實際拍出的畫面。

圖17 一般鏡頭交叉撞事故之六個鏡頭示意圖

圖17 一般鏡頭交叉撞事故之六個鏡頭示意圖

圖18 紅外鏡頭交叉撞事故之六個鏡頭示意圖

圖18 紅外鏡頭交叉撞事故之六個鏡頭示意圖

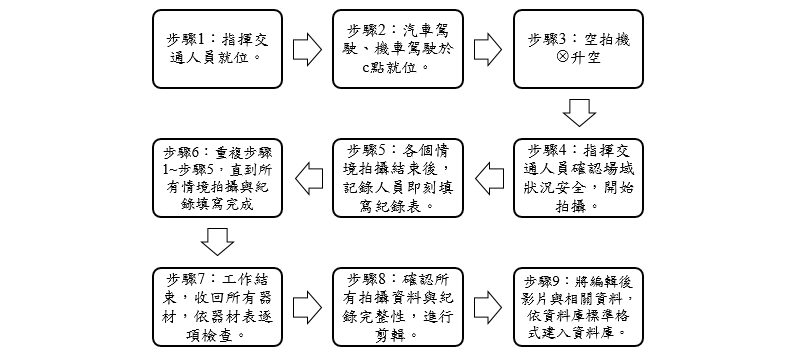

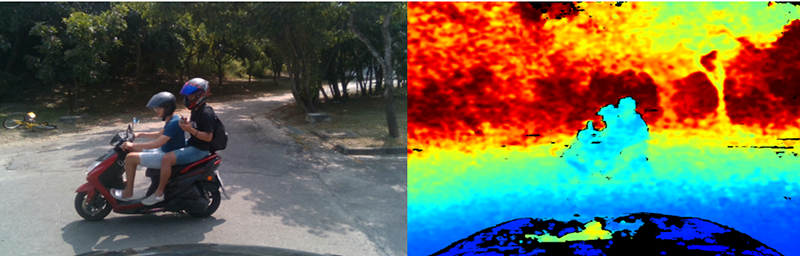

此外,圖19所示為交叉撞事故之6台攝影機現場拍攝狀況,帶有深度資訊之鏡頭實際拍出的畫面。而圖20為追撞事故情境的第三視角,圖中汽車駕駛與機車駕駛沿著右轉環狀道路同向行駛,汽車駕駛於黃色減速坡前減速與後方機車駕駛發生追撞事故情境。

圖19 帶有深度資訊的交叉撞事故之六個鏡頭示意圖

圖19 帶有深度資訊的交叉撞事故之六個鏡頭示意圖

圖20 追撞事故之第三視角

圖20 追撞事故之第三視角

圖21所示為追撞事故情境示意圖,其情境拍攝步驟說明如圖22所示。

圖21 追撞事故標準情境示意圖

圖21 追撞事故標準情境示意圖

圖22 追撞事故之標準情境拍攝步驟

圖22 追撞事故之標準情境拍攝步驟

圖23為追撞之6台攝影機現場拍攝狀況,一般鏡頭實際拍出的畫面。圖24則是追撞事故之6台攝影機現場拍攝狀況,紅外鏡頭實際拍出的畫面。而圖25為追撞事故之6台攝影機現場拍攝狀況,帶有深度資訊之鏡頭實際拍出的畫面。

圖23 追撞事故之六個鏡頭示意圖

圖23 追撞事故之六個鏡頭示意圖

圖24 紅外鏡頭追撞事故之六個鏡頭示意圖

圖24 紅外鏡頭追撞事故之六個鏡頭示意圖

圖25 帶有深度資訊的追撞事故之六個鏡頭示意圖

圖25 帶有深度資訊的追撞事故之六個鏡頭示意圖

比較深度攝影機與一般攝影機的結果

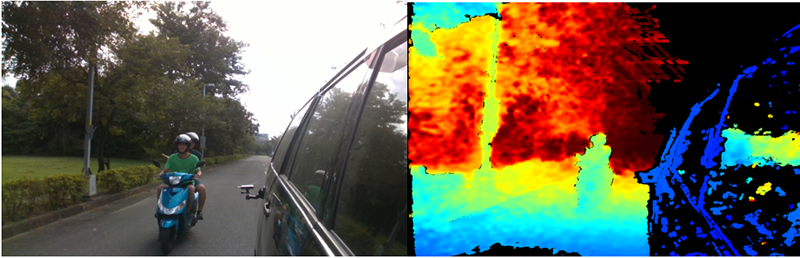

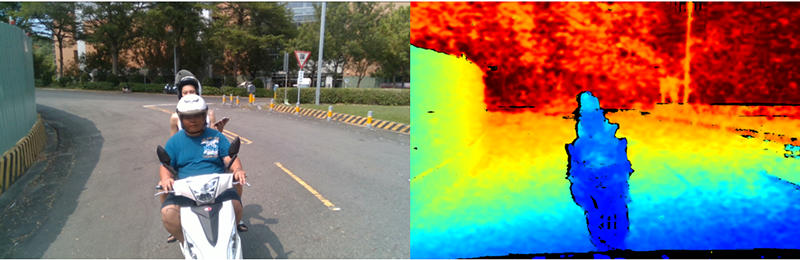

根據以上結果,依標準事故情境分成三個部分,其中第一部分為側撞情境,如圖26所示,圖左為運動攝影機拍攝結果;圖右為深度攝影機拍攝結果,深度資訊會以顏色的方式反饋。

圖26 第二攝影機(右前)拍攝結果

圖26 第二攝影機(右前)拍攝結果

圖27以第四攝影機(後方)之視角觀測側撞事故情境,運動攝影機能清楚看見路面上的雙黃線,而深度攝影機則否。

圖27 第四攝影機(後方)拍攝結果

圖27 第四攝影機(後方)拍攝結果

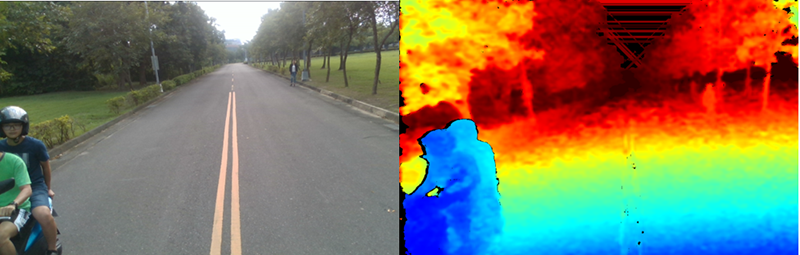

第二部分為交叉撞情境,如圖28所示,圖左為運動攝影機拍攝結果;圖右為深度攝影機拍攝結果,運動攝影機能清楚看見路面上的白色橫線,而深度攝影機拍攝結果不清晰。

圖28 第六攝影機(右後)拍攝結果

圖28 第六攝影機(右後)拍攝結果

圖29以第三攝影機(前方)之視角觀測側撞事故情境,圖中黑色部分為車子引擎蓋上的反光,亮度太強,無法得知其深度資訊。

圖29 第三攝影機(前方)拍攝結果

圖29 第三攝影機(前方)拍攝結果

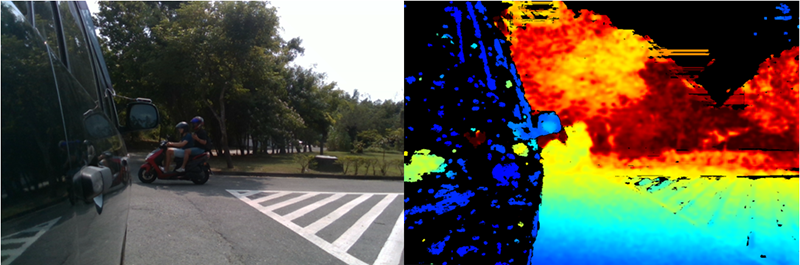

第三部分為追撞情境,如圖30所示,圖左為運動攝影機拍攝結果;圖右為深度攝影機拍攝結果,運動攝影機能看見道路的提示標誌,而深度攝影機則否。

圖30 第四攝影機(後方)拍攝結果

圖30 第四攝影機(後方)拍攝結果

深度攝影機能取得攝影機螢幕上,任一點與螢幕的距離,一般攝影機須經過算術轉換才能取得某點與螢幕的距離,過程複雜又費時,深度攝影機於拍攝過程中,記錄任一點與螢幕的距離,節省算術轉換的時間,有效降低演算法的複雜度。

車聯網發展須兼顧行車安全

隨著車聯網的快速發展,對於安全舒適的行車品質要求越來越高。在台灣地區,四輪車對二輪車的車禍事故所造成的死亡率高於其他交通事故,發展四輪車對二輪車的安全駕駛輔助系統可以大大地降低死亡與重傷人數。透過擷取車內與車外之訊息,車與外界訊息交換(V2X)的關鍵技術主要目的在於感測周圍環境的情況,如碰撞風險、不當超車、盲點範圍內的車輛、危險道路,以及視線外的前方煞車等資訊,再將可能發生的危險通知駕駛。

基於這些益處,本文主要目的在於建立四輪車與二輪車(V2M)的場域測試資料庫。經由規畫各種二輪車車禍事故的標準情境,設計了測試場域並安排相關設備。所有情景都在校園的測試場域排演,拍攝事故場景以及收集相關參數與數據供建立標準情境資料庫。此外,也同時進行所有機車事故的標準情境虛擬建模。測試影片可進一步提供目標偵測與追蹤。

(本文作者郝敏忠、林壽煦任教於國立高雄科技大學電腦與通訊工程系,陳聖文任職於資策會系統所)

首圖來源:Continental AG