將自駕功能汽車推升至Level 3以上等級所需的技術相當複雜,除了持續提升感測器訊號品質,如何在短時間內整合異質感測資訊、辨識周圍環境,並下達控制指令,也成為現階段產業致力發展的目標。

隨著自駕功能汽車發展至Level 2、Level 3,車輛開始導入越來越多先進駕駛輔助系統(ADAS),而感測器的精準度與晶片運算效能也更顯重要。因應此趨勢,相關業者除了持續投入各感測技術的優化,也開始關注異質感測器間的融合,希望能藉由軟體與硬體開發、整合,提升自駕功能汽車感知與決策的效能。

優化效能/降低成本 感測技術持續挺進

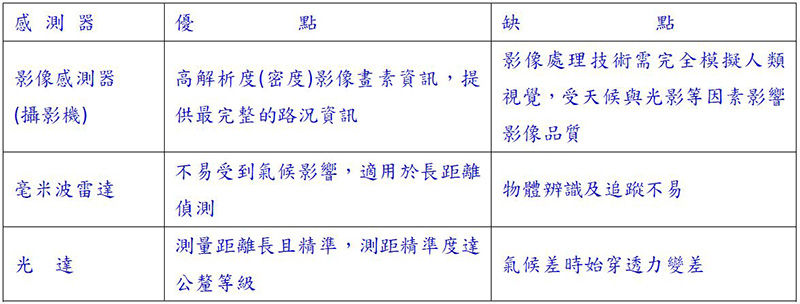

攝影機(Camera)、雷達(Radar)與光達(DAR)等感測技術,皆有其技術優勢與缺點(表1)。以目前的發展看來,攝影機影像解析度最高,能清楚辨識物體特徵與顏色,但容易受氣候等環境因素干擾,且無法準確判斷物體的距離與移動方向。

表1 自駕車感測技術比較

表1 自駕車感測技術比較

資料來源:工研院資通所

而相關廠商也持續推出解決方案,希望能更進一步優化其效能,包括提供彩色影像辨識技術;運用紅外線來提升攝影機夜視能力;將減少LED閃爍(LED Flicker Mitigation, LFM)技術導入攝影機中,使其能清楚辨識新型交通號誌;並提升攝影機的動態範圍(Dynamic Range, DR),降低氣候、光源對於系統的干擾。

雷達技術雖然不能辨識物體,但可偵測的範圍較遠且能判斷物體的距離。目前ADAS系統主要採用24GHz雷達來偵測短距及中距離範圍內的路況,支援車側防撞輔助等功能;而77/79GHz雷達則負責長距離的偵測。

不過,隨著技術的演進,工研院資通所技術總監吳文慶透露,目前已有廠商計畫使用77/79GHz來支援短、中及長距離的偵測,透過軟體下達指令切換系統模式,以調整測距。而這也意味著,未來77/79GHz將有望取代24GHz,成為車用毫米波雷達使用的主流頻段。

儘管攝影機與雷達為現階段Level 3等級以下車款的ADAS系統主要的感測器,但資策會產業情報研究所(MIC)資深產業分析師兼專案經理林信亨表示,若自駕功能汽車要發展到Level 4以上的等級,勢必需要光達(LiDAR)的輔助。因為光達在距離偵測上是最精準的,相較於雷達,其不但能偵測到物體距離,還能進一步追蹤物體移動的方向,因而成為自駕車不可或缺的關鍵元件。目前廠商也積極開發固態光達,希望能將單顆成本降至100~200美元,解決機械式光達成本過高的問題。

異質感測融合技術加持環境感知更全面

儘管廠商積極優化各個感測技術,但上述技術皆有其局限,無法運用單一技術判讀所有環境資訊,須整合異質感測資訊才能有效提升系統辨識精準度。而吳文慶表示,工研院資通所也投入感測融合技術研究,利用互補式融合、競爭式融合以及合作式融合三套演算法來執行異質感測器融合。

工研院資通所嵌入式系統與晶片技術組嵌入式視覺與繪圖技術部技術副理梁珮蓉說明,互補式演算法適用於攝影機、雷達與光達感測器偵測範圍不重疊(方位與距離範圍都不相同)的情況下,系統可以運用這套演算法將異質感測器資料結合,以取得完整的環境資訊。而競爭式融合則可以解決異質感測器間的衝突,當攝影機、雷達以及光達偵測範圍重疊,但感測或辨識結果有出入時,這套演算法會進行分析,決定要分別採用感測系統提供的哪些資訊,並以此做最終的判斷。

而合作式融合則可集結各個感測器的技術優勢,同樣適合攝影機、雷達以及光達偵測範圍重疊的情況。運用這套演算法,系統會將較早收集到的感測資訊提供給其他感測系統,作為辨識的基礎。舉例來說,光達系統偵測到100公尺處有一物體,就可透過這套演算法先將物體的輪廓、距離與方位等資訊提供給攝影機,攝影機再利用這些資訊做更進一步的影像辨識,以提升系統辨識的完整度與精準度。

梁珮蓉表示,這三套演算法將會同時導入自駕車運算系統中,並持續融入全球衛星定位系統(GPS)及慣性測量單元(IMU)等更多異質系統,使辨識範圍、環境資訊更為完善。而不論是分散式、集中式或混合式的硬體架構,皆能同時導入這三種演算法,差別只是在於,資料處理、執行融合演算法的環節會因硬體架構而有所不同。

集中式/混合式/分散式處理架構

異質感測訊號間的整合,是自駕車發展必然的課題。不過,要採用哪種處理架構執行訊號處理、環境辨識與路況判斷,業界並沒有特定作法,包括分散式、集中式及混合式處理架構,皆有廠商投入發展。

分散式運算架構中,感測裝置內會搭載處理晶片,並個別執行演算法,再將運算結果傳送至中央處理器(CPU)整合,進行環境判斷與控制。這種做法的好處是,傳輸資料量小,且能降低CPU的運算負載;此外,還能分散處理器故障時所帶來的風險,因元件分散,維修、更換的成本也較低。不過,梁珮蓉指出,分散式架構在整合感測資訊時,可能會因各處理器運算不同步造成時間延遲,進而影響系統判斷以及下控制指令的速度。

而混合式運算架構,則是在感測裝置端與CPU間增加一個運算晶片,利用此晶片將兩種感測訊號融合進行運算,再將運算結果傳送至CPU做判斷與控制。林信亨指出,就現階段而言,Tier 1汽車零組件供應商多以混合式運算架構為主要的發展方向。

集中式的運算架構中,感測器只進行基本的訊號處理(例如:雜訊過濾、誤差分析、影像標示及影像優化等),便將訊號傳送至主CPU進行運算,省去多顆晶片所帶來的成本及尺寸問題。車輛的辨識、決策與控制皆在中央處理系統進行,因此系統搭載的CPU除了要具備強大的運算能力,還須能執行多種演算法融合。

目前包括輝達(Nvidia)及瑞薩電子(Renesas Electronics)皆有投入集中式自駕車處理器與運算平台開發。其中,Nvidia的DRIVE PX系統屬於可擴充架構,能支援單一被動式散熱行動處理器、雙行動處理器和雙離散GPU等多晶片設定,因此可融合多台攝影機、雷達與超音波等感測資料,使演算法得以準確解讀車輛周遭的360度完整環境。

瑞薩車用事業部市場行銷部經理何吉哲表示,不同自駕功能等級的汽車,對於硬體架構的需求也會不同,如目前市面上Level 2以下的車款為主,系統不用執行太複雜的運算與決策,車廠多傾向採用分散式架構。因此,該公司除了提供用於集中式架構的高階CPU,也提供適用於分散式架構的中小型CPU,在感測端執行環景貼合、影像判讀等運算處理工作。

而針對Level 3以上的自駕功能汽車,該公司則提供集中式自駕車運算平台,將運算功能及硬體加速器整合至中央處理系統,進行感測融合與決策,降低硬體占積與成本。此外,何吉哲也透露,Level 3以上的自駕功能汽車,至少須運用3至4顆高階CPU來組成中央處理系統。

滿足自駕車即時傳輸 傳輸介面/線材不可忽視

隨著汽車自動駕駛等級的演進,車輛將會融入越來越多的感測器,因此除了須提升晶片的處理效能,汽車所搭載的傳輸介面與線材,也須能提供低延遲且大資料量的傳輸,以滿足自駕車即時傳輸的要求。

何吉哲說明,汽車本身的體積大、結構複雜,而隨著汽車融入越來越多電子元件,其傳輸介面與走線也會越來越複雜。因此,如何降低資料從感測端傳輸至處理器過程中的訊號耗損,並靈活應對各種周邊系統所需的傳輸介面,皆是車用IC在設計時須考量的重點。

資料傳輸品質與速率對於集中式架構尤其重要。集中式架構須將所有感測資料傳送至中央處理系統運算,資料傳輸量更為龐大。對此,何吉哲說明,早期汽車多搭載PCIe(PCI Express)、CVBS等通訊介面。而隨著ADAS系統功能演進,感測器資料量也越來越龐大,因此許多汽車也開始導入MIPI、車用乙太網路(Ethernet AVB)、FPD Link等高速傳輸介面,來提升訊號品質與傳輸速率。

另外,梁珮蓉也提到,由於自駕車感測端至處理器的傳輸路徑可能長達5、6公尺,因此在線材上會選用同軸纜線(Coaxial Cable)進行傳輸,改善訊號衰減的問題。

影像辨識系統支援即時路況平台

自駕車要發展到Level 4以上,除了須具備優異的感知能力,還必須隨時掌握路況,才能做出正確的判斷與控制。針對此議題,Mobileye台灣授權合作廠商艾德斯科技(ADAS Mobile Tech)董事長溫峻瑜表示,Mobileye也已投入道路體驗管理(Road Experience Management, REM)地圖繪製,並將相關軟體整合進其影像辨識解決方案中,預計2019年開始在全球各地建置即時路況雲端平台。

溫峻瑜進一步說明,Mobileye 2017年底開始量產的新一代系統單晶片EyeQ4,內建道路資訊收集軟體,包括BMW、日產、福斯等車廠推出的200萬輛新車都有搭載此晶片,因此可藉由這些車輛上的影像辨識系統在全球各地收集低頻寬資料封包,並將資料匯集至雲端,產生RoadBook可行車路徑、車道/道路邊界以及靜止路標等資料,進行即時路況更新。